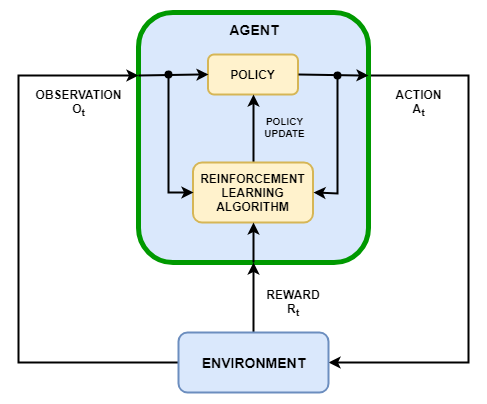

Цель обучения с подкреплением состоит в том, чтобы настроить агента для выполнения задачи в неопределенном окружении. Агент получает наблюдения и вознаграждение от окружения и посылает туда действия. Вознаграждение является мерой того, насколько успешно действие относительно выполнения цели задачи.

Агент содержит два компонента: политика и алгоритм обучения.

Политика является отображением, которое выбирает действия на основе наблюдений от среды. Как правило, политика представляет собой аппроксимирующую функцию с настраиваемыми параметрами, например, глубокую нейронную сеть.

Алгоритм обучения постоянно обновляет параметры политики на основе действий, наблюдений и вознаграждений. Цель алгоритма обучения состоит в том, чтобы найти оптимальную политику, которая максимизирует совокупное вознаграждение, полученное во время задачи.

В зависимости от алгоритма обучения агент поддерживает одну или несколько параметризованных функциональных аппроксимаций для настройки политики. Существует два типа функциональных аппроксимаций.

Критики — Для заданного наблюдения и действия, критик находит ожидаемое значение долгосрочного будущего вознаграждения за задачу.

Агенты — Для заданного наблюдения, агент находит действие, которое максимизирует долгосрочное будущее вознаграждение

Для получения дополнительной информации о создании функциональных аппроксимаций актёра и критика смотрите, Создают Представления Функции ценности и политика.

Программное обеспечение Reinforcement Learning Toolbox™ предоставляет следующих встроенных агентов. Каждый агент может быть обучен в окружениях с непрерывными или дискретными пространствами наблюдений и нижеследующими пространствами действий.

| Агент | Действия |

|---|---|

| Агенты Q-обучения | Дискретный |

| Агенты SARSA | Дискретный |

| Глубокие агенты Q-сети | Дискретный |

| Агенты градиента политики | Дискретный или непрерывный |

| Глубоко детерминированные агенты градиента политики | Непрерывный |

| Задержанный близнецами глубоко детерминированные агенты градиента политики | Непрерывный |

| Агенты критика агента | Дискретный или непрерывный |

| Ближайшие агенты оптимизации политики | Дискретный или непрерывный |

Можно также обучить политики с помощью других алгоритмов обучения путем создания пользовательского агента. Для этого вы создаете подкласс пользовательского класса агента, задавая поведение агента с помощью набора необходимых и дополнительных методов. Для получения дополнительной информации смотрите Пользовательских Агентов.

rlACAgent | rlDDPGAgent | rlDQNAgent | rlPGAgent | rlPPOAgent | rlQAgent | rlSARSAAgent