В этом примере показано, как настроить гиперпараметры модели машины опорных векторов (SVM) классификации при помощи оптимизации гиперпараметра в приложении Classification Learner. Сравните эффективность набора тестов обученного optimizable SVM к той из лучше всего выполняющей предварительно установленной модели SVM.

В Командном окне MATLAB® загрузите ionosphere набор данных, и составляет таблицу, содержащую данные. Разделите таблицу на наборы обучающих данных и наборы тестов.

load ionosphere tbl = array2table(X); tbl.Y = Y; rng('default') % For reproducibility of the data split partition = cvpartition(Y,'Holdout',0.15); idxTrain = training(partition); % Indices for the training set tblTrain = tbl(idxTrain,:); tblTest = tbl(~idxTrain,:);

Открытый Classification Learner. Кликните по вкладке Apps, и затем кликните по стреле справа от раздела Apps, чтобы открыть галерею Apps. В группе Machine Learning and Deep Learning нажмите Classification Learner.

На вкладке Classification Learner, в разделе File, выбирают New Session > From Workspace.

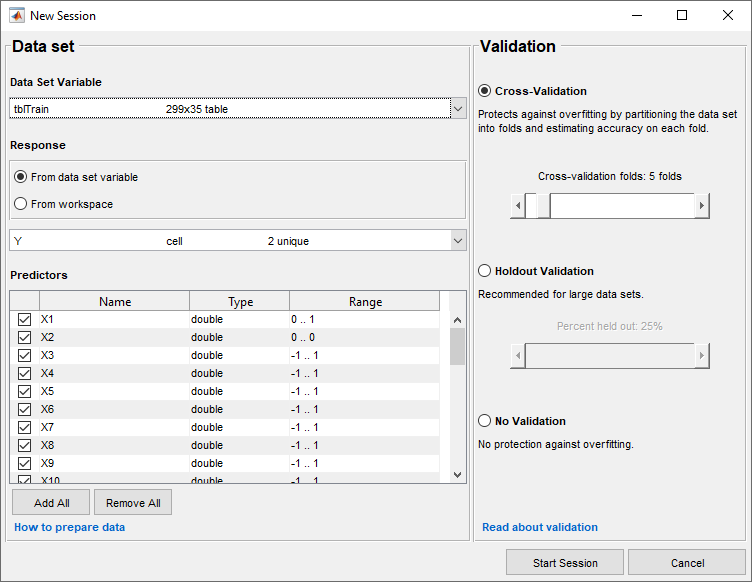

В диалоговом окне New Session выберите tblTrain таблица из списка Data Set Variable.

Как показано в диалоговом окне, приложение выбирает переменные отклика и переменные предикторы. Переменной отклика по умолчанию является Y. Опция валидации по умолчанию является 5-кратной перекрестной проверкой, чтобы защитить от сверхподбора кривой. В данном примере не изменяйте настройки по умолчанию.

Чтобы принять опции по умолчанию и продолжиться, нажмите Start Session.

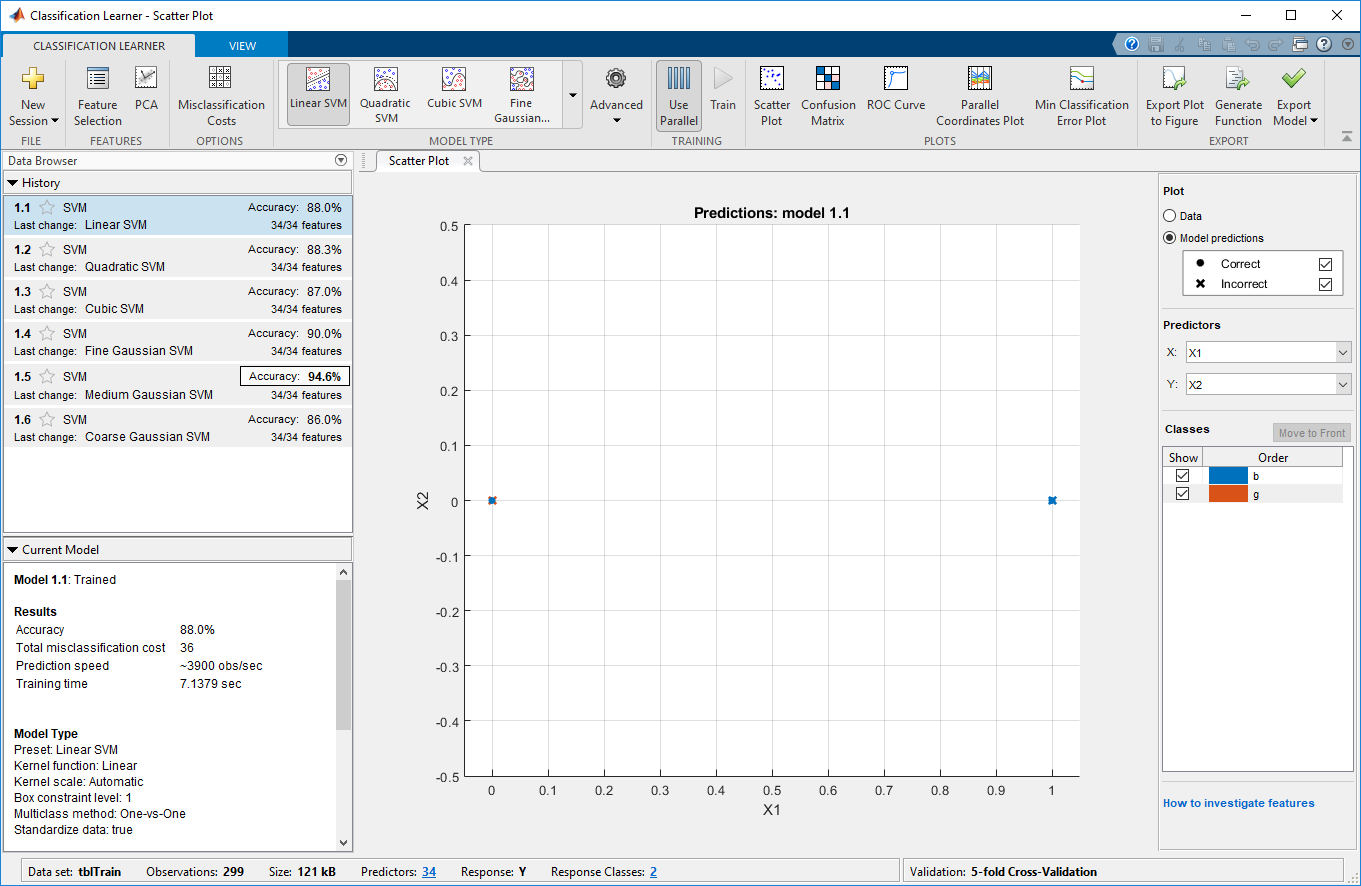

Обучите все предварительно установленные модели SVM. На вкладке Classification Learner, в разделе Model Type, кликают по стреле, чтобы открыть галерею. В группе Support Vector Machines нажмите All SVMs. В разделе Training нажмите Train. Приложение обучает один из каждого типа модели SVM и отображает модели в списке History.

Совет

Если у вас есть Parallel Computing Toolbox™, диалоговое окно Opening Pool открывается в первый раз, когда вы нажимаете Train (или когда вы нажимаете Train снова после длительного периода времени). Диалоговое окно остается открытым, в то время как приложение открывает параллельный пул рабочих. В это время вы не можете взаимодействовать с программным обеспечением. После того, как пул открывается, можно обучить многоуровневые модели одновременно и продолжить работать.

Примечание

Валидация вводит некоторую случайность в результаты. Ваши результаты проверки допустимости модели могут варьироваться от результатов, показанных в этом примере.

Выберите optimizable модель SVM, чтобы обучаться. На вкладке Classification Learner, в разделе Model Type, кликают по стреле, чтобы открыть галерею. В группе Support Vector Machines нажмите Optimizable SVM. Приложение отключает кнопку Use Parallel, когда вы выбираете optimizable модель.

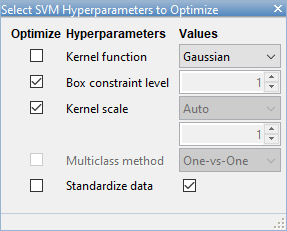

Выберите гиперпараметры модели, чтобы оптимизировать. В разделе Model Type выберите Advanced > Advanced. Приложение открывает диалоговое окно, в котором можно установить флажки Optimize для гиперпараметров, которые вы хотите оптимизировать. По умолчанию все флажки для доступных гиперпараметров устанавливаются. В данном примере снимите флажки Optimize для Kernel function и Standardize data. По умолчанию приложение отключает флажок Optimize для Kernel scale каждый раз, когда функция ядра имеет фиксированное значение кроме Gaussian. Выберите Gaussian функция ядра, и устанавливает флажок Optimize для Kernel scale.

В разделе Training нажмите Train.

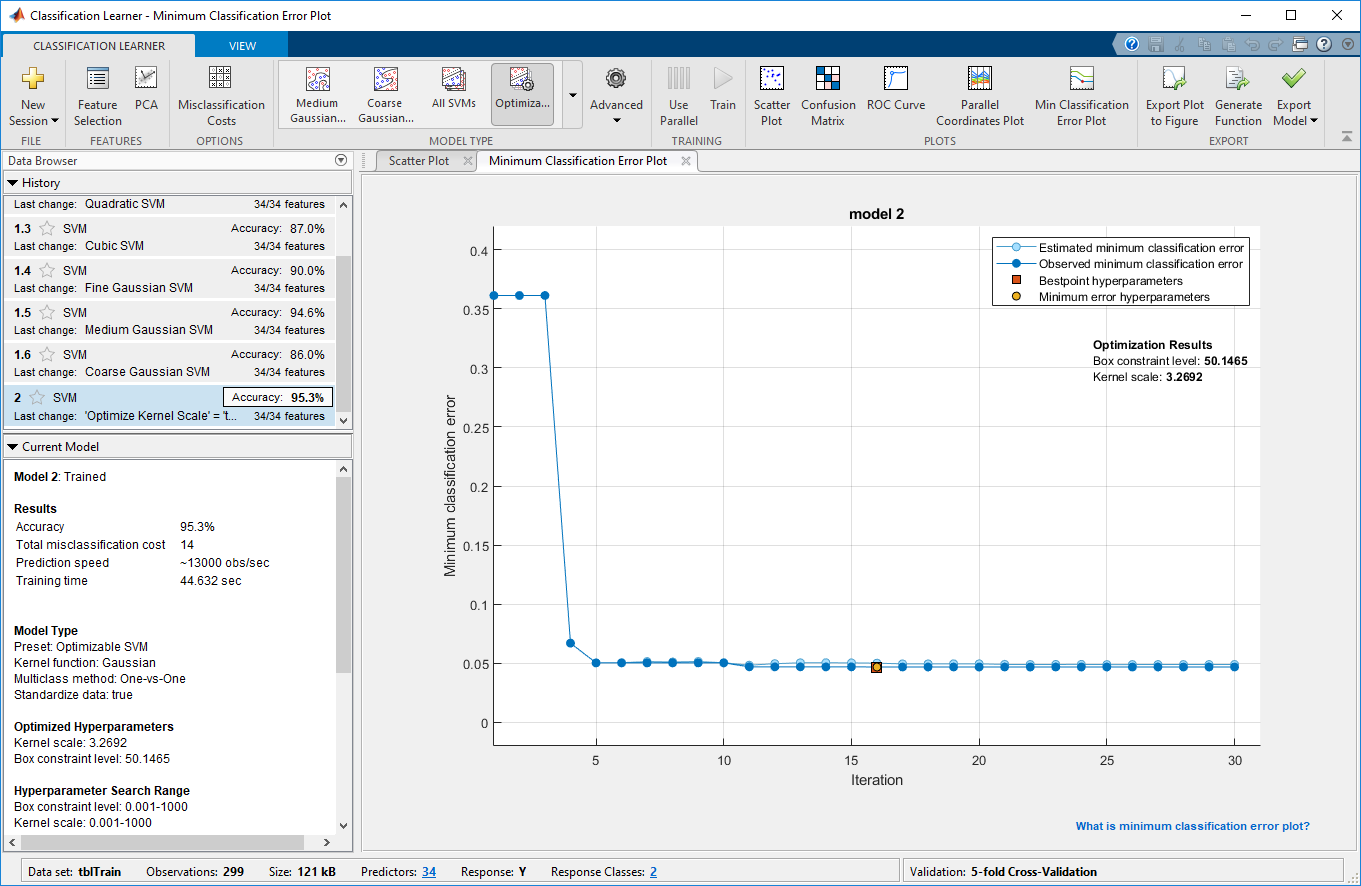

Отображения приложения Minimum Classification Error Plot, когда это запускает процесс оптимизации. В каждой итерации приложение пробует различную комбинацию гиперзначений параметров и обновляет график с минимальной ошибкой классификации валидаций, наблюдаемой до той итерации, обозначенной в темно-синем. Когда приложение завершает процесс оптимизации, оно выбирает набор оптимизированных гиперпараметров, обозначенных красным квадратом. Для получения дополнительной информации смотрите Минимальную Диаграмму погрешностей Классификации.

Списки приложений оптимизированные гиперпараметры и в верхнем правом углу графика и в разделе Optimized Hyperparameters панели Current Model.

Примечание

В общем случае результаты оптимизации не восстанавливаемы.

Сравните обученные предварительно установленные модели SVM с обученной optimizable моделью. В списке History приложение подсвечивает самую высокую валидацию Accuracy путем выделения его в поле. В этом примере обученная optimizable модель SVM превосходит шесть предварительно установленных моделей по характеристикам.

Обученная optimizable модель не всегда имеет более высокую точность, чем обученные предварительно установленные модели. Если обученная optimizable модель не выполняет хорошо, можно попытаться получить лучшие результаты путем выполнения оптимизации для дольше. В разделе Model Type выберите Advanced > Optimizer Options. В диалоговом окне увеличьте значение Iterations. Например, можно дважды кликнуть значение по умолчанию 30 и введите значение 60.

Поскольку гиперпараметр, настраивающийся часто, приводит к сверхподобранным моделям, проверяйте эффективность набора тестов модели SVM оптимизированными гиперпараметрами и сравните его с эффективностью лучшей предварительно установленной модели SVM. Начните путем экспорта этих двух моделей в рабочее пространство MATLAB.

В списке History выберите модель Medium Gaussian SVM. На вкладке Classification Learner, в разделе Export, выбирают Export Model > Export Model. В диалоговом окне назовите модель gaussianSVM.

В списке History выберите модель Optimizable SVM. На вкладке Classification Learner, в разделе Export, выбирают Export Model > Export Model. В диалоговом окне назовите модель optimizableSVM.

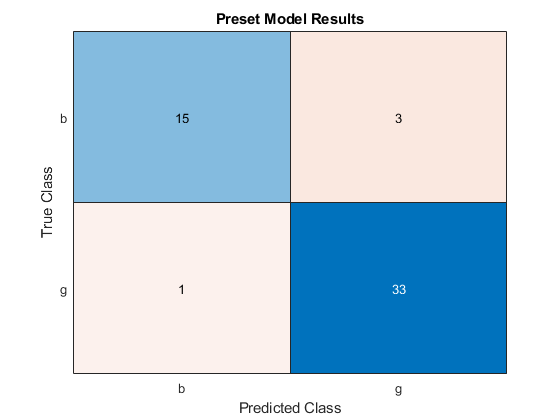

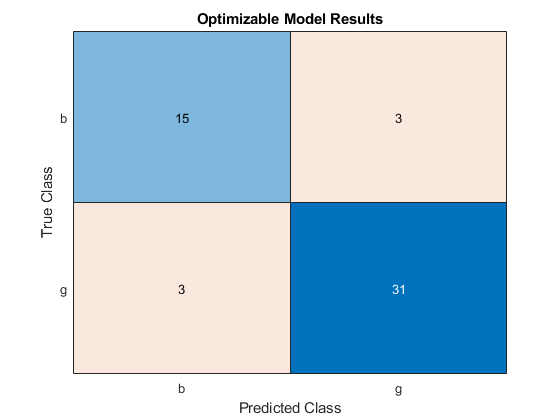

Вычислите точность этих двух моделей на tblTest данные. В командном окне MATLAB используйте predictFcn функция в каждой экспортируемой структуре модели, чтобы предсказать значения отклика данных о наборе тестов. Затем используйте матрицы беспорядка, чтобы визуализировать результаты. Вычислите и сравните значения точности для моделей на данных о наборе тестов.

testY = tblTest.Y; labels = gaussianSVM.predictFcn(tblTest); figure cm = confusionchart(testY,labels); title('Preset Model Results') optLabels = optimizableSVM.predictFcn(tblTest); figure optcm = confusionchart(testY,optLabels); title('Optimizable Model Results') cmvalues = cm.NormalizedValues; optcmvalues = optcm.NormalizedValues; presetAccuracy = sum(diag(cmvalues))/sum(cmvalues,'all')*100 optAccuracy = sum(diag(optcmvalues))/sum(optcmvalues,'all')*100

presetAccuracy = 92.3077 optAccuracy = 88.4615

В этом примере обученная optimizable модель SVM не выполняет, а также обученная предварительно установленная модель на данных о наборе тестов.