Агент обучения с подкреплением

Reinforcement Learning Toolbox

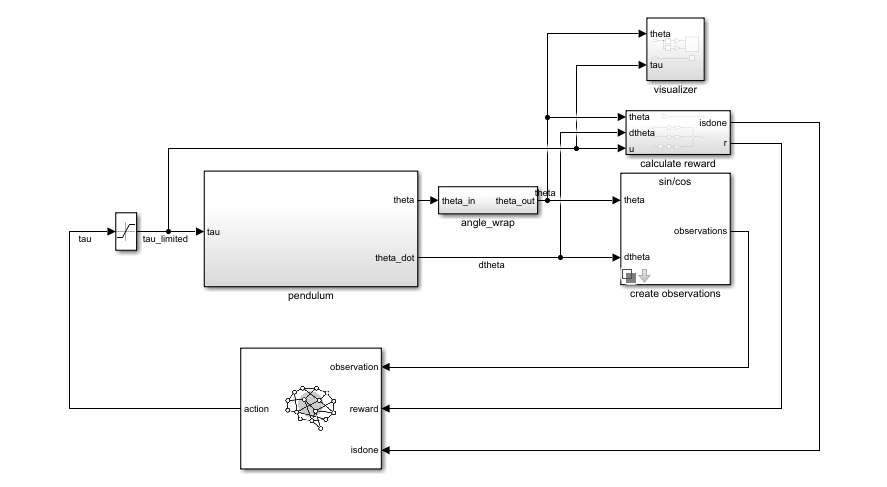

Используйте блок RL Agent для симуляции и обучения агента обучения с подкреплением в Simulink®. Вы связываете блок с агентом, хранящимся в MATLAB® рабочая область или словарь данных как объект агента, такой как rlACAgent или rlDDPGAgent объект. Вы соединяете блок так, чтобы он получил наблюдение и вычисленное вознаграждение. Например, рассмотрите следующий блок rlSimplePendulumModel модель.

The observation входной порт блока RL Agent получает сигнал, который выводится из мгновенных угла и скорости вращения маятника. The reward порт получает вознаграждение, рассчитанное из тех же двух значений и приложенного действия. Вы конфигурируете наблюдения и расчеты вознаграждения, соответствующие вашей системе.

Блок использует агента, чтобы сгенерировать действие на основе наблюдений и вознаграждения, которое вы предоставляете. Соедините action выходной порт на соответствующий вход для вашей системы. Для образца, в rlSimplePendulumModel, а action порт является крутящим моментом, приложенным к системе маятника. Для получения дополнительной информации об этой модели см. «Train агента DQN к качанию» и «Баланс маятника».

Чтобы обучить агента обучения с подкреплением в Simulink, вы генерируете окружение из модели Simulink. Затем вы создаете и конфигурируете агента для обучения с этим окружением. Для получения дополнительной информации см. Раздел «Создание окружений обучения с подкреплением Simulink». Когда вы звоните train используя окружение, train моделирует модель и обновляет агента, связанного с блоком.