Слой Long short-term memory (LSTM)

Слой LSTM изучает долгосрочные зависимости между временными шагами в данных о последовательности и временных рядах.

Слой выполняет аддитивные взаимодействия, которые могут помочь улучшить поток градиента по длинным последовательностям во время обучения.

layer = lstmLayer(numHiddenUnits)NumHiddenUnits свойство.

layer = lstmLayer(numHiddenUnits,Name,Value)OutputMode, Активации, состояние, параметры и инициализация, изучают уровень и регуляризацию и Name свойства с помощью одного или нескольких аргументов пары "имя-значение". Можно задать несколько аргументов пары "имя-значение". Заключите каждое имя свойства в кавычки.

NumHiddenUnits — Количество скрытых модулейКоличество скрытых модулей (также известный как скрытый размер), заданный как положительное целое число.

Количество скрытых модулей соответствует объему информации, который помнят между временными шагами (скрытое состояние). Скрытое состояние может содержать информацию от всех предыдущих временных шагов, независимо от длины последовательности. Если количество скрытых модулей является слишком большим, то слой может сверхсоответствовать к обучающим данным. Это значение может варьироваться от нескольких дюжин до нескольких тысяч.

Скрытое состояние не ограничивает количество временных шагов, обрабатываются в итерации. Чтобы разделить ваши последовательности в меньшие последовательности для обучения, используйте 'SequenceLength' опция в trainingOptions.

Пример: 200

OutputMode — Формат выхода'sequence' (значение по умолчанию) | 'last'Формат выхода, заданного как одно из следующего:

'sequence' – Выведите полную последовательность.

'last' – Выведите последний временной шаг последовательности.

InputSize — Введите размер'auto' (значение по умолчанию) | положительное целое число Введите размер, заданный как положительное целое число или 'auto'. Если InputSize 'auto', затем программное обеспечение автоматически присваивает входной размер в учебное время.

Пример: 100

StateActivationFunction — Функция активации, чтобы обновить ячейку и скрытое состояние'tanh' (значение по умолчанию) | 'softsign'Функция активации, чтобы обновить ячейку и скрытое состояние, заданное как одно из следующего:

'tanh' – Используйте гиперболическую функцию тангенса (tanh).

'softsign' – Используйте функцию softsign .

Слой использует эту опцию в качестве функции в вычислениях, чтобы обновить ячейку и скрытое состояние. Для получения дополнительной информации о том, как функции активации используются в слое LSTM, видят Слой Long Short-Term Memory.

GateActivationFunction — Функция активации, чтобы примениться к логическим элементам'sigmoid' (значение по умолчанию) | 'hard-sigmoid'Функция активации, чтобы примениться к логическим элементам, заданным как одно из следующего:

'sigmoid' – Используйте сигмоидальную функцию .

'hard-sigmoid' – Используйте трудную сигмоидальную функцию

Слой использует эту опцию в качестве функции в вычислениях для входа, выходе, и забывают логический элемент. Для получения дополнительной информации о том, как функции активации используются в слое LSTM, видят Слой Long Short-Term Memory.

CellState — Начальное значение состояния ячейкиНачальное значение состояния ячейки, заданного как NumHiddenUnits- 1 числовой вектор. Это значение соответствует состоянию ячейки на временном шаге 0.

После установки этого свойства, вызовов resetState функционируйте устанавливает состояние ячейки на это значение.

HiddenState — Начальное значение скрытого состоянияНачальное значение скрытого состояния, заданного как NumHiddenUnits- 1 числовой вектор. Это значение соответствует скрытому состоянию на временном шаге 0.

После установки этого свойства, вызовов resetState функционируйте устанавливает скрытое состояние на это значение.

InputWeightsInitializer — Функция, чтобы инициализировать входные веса'glorot' (значение по умолчанию) | 'he' | 'orthogonal' | 'narrow-normal' | 'zeros' | 'ones' | указатель на функциюФункция, чтобы инициализировать входные веса, заданные как одно из следующего:

'glorot' – Инициализируйте входные веса с инициализатором Glorot [4] (также известный как инициализатор Ксавьера). Инициализатор Glorot независимо выборки от равномерного распределения с нулевым средним значением и отклонением 2/(InputSize + numOut), где numOut = 4*NumHiddenUnits.

'he' – Инициализируйте входные веса с Ним инициализатор [5]. Он выборки инициализатора от нормального распределения с нулевым средним значением и отклонением 2/InputSize.

'orthogonal' – Инициализируйте входные веса с Q, ортогональная матрица, данная разложением QR Z = Q R для случайного матричного Z, произведенного от модульного нормального распределения. [6]

'narrow-normal' – Инициализируйте входные веса путем независимой выборки от нормального распределения с нулевым средним и стандартным отклонением 0.01.

'zeros' – Инициализируйте входные веса с нулями.

'ones' – Инициализируйте входные веса с единицами.

Указатель на функцию – Инициализирует входные веса с пользовательской функцией. Если вы задаете указатель на функцию, то функция должна иметь форму weights = func(sz), где sz размер входных весов.

Слой только инициализирует входные веса когда InputWeights свойство пусто.

Типы данных: char | string | function_handle

RecurrentWeightsInitializer — Функция, чтобы инициализировать текущие веса'orthogonal' (значение по умолчанию) | 'glorot' | 'he' | 'narrow-normal' | 'zeros' | 'ones' | указатель на функциюФункция, чтобы инициализировать текущие веса, заданные как одно из следующего:

'orthogonal' – Инициализируйте текущие веса с Q, ортогональная матрица, данная разложением QR Z = Q R для случайного матричного Z, произведенного от модульного нормального распределения. [6]

'glorot' – Инициализируйте текущие веса с инициализатором Glorot [4] (также известный как инициализатор Ксавьера). Инициализатор Glorot независимо выборки от равномерного распределения с нулевым средним значением и отклонением 2/(numIn + numOut), где numIn = NumHiddenUnits и numOut = 4*NumHiddenUnits.

'he' – Инициализируйте текущие веса с Ним инициализатор [5]. Он выборки инициализатора от нормального распределения с нулевым средним значением и отклонением 2/NumHiddenUnits.

'narrow-normal' – Инициализируйте текущие веса путем независимой выборки от нормального распределения с нулевым средним и стандартным отклонением 0.01.

'zeros' – Инициализируйте текущие веса с нулями.

'ones' – Инициализируйте текущие веса с единицами.

Указатель на функцию – Инициализирует текущие веса с пользовательской функцией. Если вы задаете указатель на функцию, то функция должна иметь форму weights = func(sz), где sz размер текущих весов.

Слой только инициализирует текущие веса когда RecurrentWeights свойство пусто.

Типы данных: char | string | function_handle

BiasInitializer — Функция, чтобы инициализировать смещение'unit-forget-gate' (значение по умолчанию) | 'narrow-normal' | 'ones' | указатель на функциюФункция, чтобы инициализировать смещение, заданное как одно из следующего:

'unit-forget-gate' – Инициализируйте забыть смещение затвора с единицами и остающиеся смещения с нулями.

'narrow-normal' – Инициализируйте смещение путем независимой выборки от нормального распределения с нулевым средним и стандартным отклонением 0.01.

'ones' – Инициализируйте смещение с единицами.

Указатель на функцию – Инициализирует смещение с пользовательской функцией. Если вы задаете указатель на функцию, то функция должна иметь форму bias = func(sz), где sz размер смещения.

Слой только инициализирует смещение когда Bias свойство пусто.

Типы данных: char | string | function_handle

InputWeights — Введите веса[] (значение по умолчанию) | матрицаВведите веса, заданные как матрица.

Входная матрица веса является конкатенацией четырех входных матриц веса для компонентов (логические элементы) в слое LSTM. Эти четыре матрицы конкатенированы вертикально в следующем порядке:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Входные веса являются learnable параметрами. При обучении сети, если InputWeights непусто, затем trainNetwork использует InputWeights свойство как начальное значение. Если InputWeights пусто, затем trainNetwork использует инициализатор, заданный InputWeightsInitializer.

В учебное время, InputWeights 4*NumHiddenUnits- InputSize матрица.

RecurrentWeights — Текущие веса[] (значение по умолчанию) | матрицаТекущие веса, заданные как матрица.

Текущая матрица веса является конкатенацией четырех текущих матриц веса для компонентов (логические элементы) в слое LSTM. Эти четыре матрицы вертикально конкатенированы в следующем порядке:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Текущие веса являются learnable параметрами. При обучении сети, если RecurrentWeights непусто, затем trainNetwork использует RecurrentWeights свойство как начальное значение. Если RecurrentWeights пусто, затем trainNetwork использует инициализатор, заданный RecurrentWeightsInitializer.

В учебное время RecurrentWeights 4*NumHiddenUnits- NumHiddenUnits матрица.

Bias — Смещения слоя[] (значение по умолчанию) | числовой векторСлой смещает для слоя LSTM, заданного как числовой вектор.

Вектор смещения является конкатенацией четырех векторов смещения для компонентов (логические элементы) в слое LSTM. Эти четыре вектора конкатенированы вертикально в следующем порядке:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Смещения слоя являются learnable параметрами. При обучении сети, если Bias непусто, затем trainNetwork использует Bias свойство как начальное значение. Если Bias пусто, затем trainNetwork использует инициализатор, заданный BiasInitializer.

В учебное время, Bias 4*NumHiddenUnits- 1 числовой вектор.

InputWeightsLearnRateFactor — Фактор темпа обучения для входных весовФактор темпа обучения для входных весов, заданных в виде числа или числового вектора 1 на 4.

Программное обеспечение умножает этот фактор на глобальный темп обучения, чтобы определить фактор темпа обучения для входных весов слоя. Например, если InputWeightsLearnRateFactor 2, затем фактором темпа обучения для входных весов слоя является дважды текущий глобальный темп обучения. Программное обеспечение определяет глобальный темп обучения на основе настроек, заданных с trainingOptions функция.

Управлять значением фактора темпа обучения для четырех отдельных матриц в InputWeights, задайте вектор 1 на 4. Записи InputWeightsLearnRateFactor соответствуйте фактору темпа обучения следующего:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Чтобы задать то же значение для всех матриц, задайте неотрицательный скаляр.

Пример 2

Пример:

[1 2 1 1]

RecurrentWeightsLearnRateFactor — Фактор темпа обучения для текущих весовФактор темпа обучения для текущих весов, заданных в виде числа или числового вектора 1 на 4.

Программное обеспечение умножает этот фактор на глобальный темп обучения, чтобы определить темп обучения для текущих весов слоя. Например, если RecurrentWeightsLearnRateFactor 2, затем темп обучения для текущих весов слоя является дважды текущим глобальным темпом обучения. Программное обеспечение определяет глобальный темп обучения на основе настроек, заданных с trainingOptions функция.

Управлять значением фактора темпа обучения для четырех отдельных матриц в RecurrentWeights, задайте вектор 1 на 4. Записи RecurrentWeightsLearnRateFactor соответствуйте фактору темпа обучения следующего:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Чтобы задать то же значение для всех матриц, задайте неотрицательный скаляр.

Пример 2

Пример:

[1 2 1 1]

BiasLearnRateFactor — Фактор темпа обучения для смещенийФактор темпа обучения для смещений, заданных как неотрицательный скаляр или числовой вектор 1 на 4.

Программное обеспечение умножает этот фактор на глобальный темп обучения, чтобы определить темп обучения для смещений в этом слое. Например, если BiasLearnRateFactor 2, затем темп обучения для смещений в слое является дважды текущим глобальным темпом обучения. Программное обеспечение определяет глобальный темп обучения на основе настроек, заданных с trainingOptions функция.

Управлять значением фактора темпа обучения для четырех отдельных матриц в Bias, задайте вектор 1 на 4. Записи BiasLearnRateFactor соответствуйте фактору темпа обучения следующего:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Чтобы задать то же значение для всех матриц, задайте неотрицательный скаляр.

Пример 2

Пример:

[1 2 1 1]

InputWeightsL2Factor — Фактор регуляризации L2 для входных весовФактор регуляризации L2 для входных весов, заданных в виде числа или числового вектора 1 на 4.

Программное обеспечение умножает этот фактор на глобальный фактор регуляризации L2, чтобы определить фактор регуляризации L2 для входных весов слоя. Например, если InputWeightsL2Factor 2, затем фактором регуляризации L2 для входных весов слоя является дважды текущий глобальный фактор регуляризации L2. Программное обеспечение определяет фактор регуляризации L2 на основе настроек, заданных с trainingOptions функция.

Управлять значением фактора регуляризации L2 для четырех отдельных матриц в InputWeights, задайте вектор 1 на 4. Записи InputWeightsL2Factor соответствуйте фактору регуляризации L2 следующего:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Чтобы задать то же значение для всех матриц, задайте неотрицательный скаляр.

Пример 2

Пример:

[1 2 1 1]

RecurrentWeightsL2Factor — Фактор регуляризации L2 для текущих весовФактор регуляризации L2 для текущих весов, заданных в виде числа или числового вектора 1 на 4.

Программное обеспечение умножает этот фактор на глобальный фактор регуляризации L2, чтобы определить фактор регуляризации L2 для текущих весов слоя. Например, если RecurrentWeightsL2Factor 2, затем фактором регуляризации L2 для текущих весов слоя является дважды текущий глобальный фактор регуляризации L2. Программное обеспечение определяет фактор регуляризации L2 на основе настроек, заданных с trainingOptions функция.

Управлять значением фактора регуляризации L2 для четырех отдельных матриц в RecurrentWeights, задайте вектор 1 на 4. Записи RecurrentWeightsL2Factor соответствуйте фактору регуляризации L2 следующего:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Чтобы задать то же значение для всех матриц, задайте неотрицательный скаляр.

Пример 2

Пример:

[1 2 1 1]

BiasL2Factor — Фактор регуляризации L2 для смещенийФактор регуляризации L2 для смещений, заданных как неотрицательный скаляр или числовой вектор 1 на 4.

Программное обеспечение умножает этот фактор на глобальный фактор регуляризации L2, чтобы определить регуляризацию L2 для смещений в этом слое. Например, если BiasL2Factor 2, затем регуляризация L2 для смещений в этом слое является дважды глобальным фактором регуляризации L2. Можно задать глобальный фактор регуляризации L2 использование trainingOptions функция.

Управлять значением фактора регуляризации L2 для четырех отдельных матриц в Bias, задайте вектор 1 на 4. Записи BiasL2Factor соответствуйте фактору регуляризации L2 следующего:

Введите логический элемент

Забудьте логический элемент

Кандидат ячейки

Выведите логический элемент

Чтобы задать то же значение для всех матриц, задайте неотрицательный скаляр.

Пример 2

Пример:

[1 2 1 1]

Name — Имя слоя'' (значение по умолчанию) | вектор символов | представляет скаляр в виде строкиИмя слоя, заданное как вектор символов или скаляр строки. Если Name установлен в '', затем программное обеспечение автоматически присваивает имя в учебное время.

Типы данных: char | string

NumInputs — Количество входных параметровКоличество входных параметров слоя. Этот слой принимает один вход только.

Типы данных: double

InputNames — Введите имена{'in'} (значение по умолчанию)Введите имена слоя. Этот слой принимает один вход только.

Типы данных: cell

NumOutputs — Количество выходных параметровКоличество выходных параметров слоя. Этот слой имеет один выход только.

Типы данных: double

OutputNames — Выведите имена{'out'} (значение по умолчанию)Выведите имена слоя. Этот слой имеет один выход только.

Типы данных: cell

Создайте слой LSTM с именем 'lstm1' и 100 скрытых модулей.

layer = lstmLayer(100,'Name','lstm1')

layer =

LSTMLayer with properties:

Name: 'lstm1'

Hyperparameters

InputSize: 'auto'

NumHiddenUnits: 100

OutputMode: 'sequence'

StateActivationFunction: 'tanh'

GateActivationFunction: 'sigmoid'

Learnable Parameters

InputWeights: []

RecurrentWeights: []

Bias: []

State Parameters

HiddenState: []

CellState: []

Show all properties

Включайте слой LSTM в Layer массив.

inputSize = 12;

numHiddenUnits = 100;

numClasses = 9;

layers = [ ...

sequenceInputLayer(inputSize)

lstmLayer(numHiddenUnits)

fullyConnectedLayer(numClasses)

softmaxLayer

classificationLayer]layers =

5x1 Layer array with layers:

1 '' Sequence Input Sequence input with 12 dimensions

2 '' LSTM LSTM with 100 hidden units

3 '' Fully Connected 9 fully connected layer

4 '' Softmax softmax

5 '' Classification Output crossentropyex

Обучите сеть LSTM глубокого обучения для классификации последовательностей к метке.

Загрузите японский набор данных Гласных как описано в [1] и [2]. XTrain массив ячеек, содержащий 270 последовательностей различной длины с размерностью признаков 12. Y категориальный вектор меток 1,2..., 9. Записи в XTrain матрицы с 12 строками (одна строка для каждого признака) и различным количеством столбцов (один столбец для каждого временного шага).

[XTrain,YTrain] = japaneseVowelsTrainData;

Визуализируйте первые временные ряды в графике. Каждая линия соответствует функции.

figure

plot(XTrain{1}')

title("Training Observation 1")

numFeatures = size(XTrain{1},1);

legend("Feature " + string(1:numFeatures),'Location','northeastoutside')

Задайте архитектуру сети LSTM. Задайте входной размер как 12 (количество функций входных данных). Задайте слой LSTM, чтобы иметь 100 скрытых модулей и вывести последний элемент последовательности. Наконец, задайте девять классов включением полносвязного слоя размера 9, сопровождаемый softmax слоем и слоем классификации.

inputSize = 12; numHiddenUnits = 100; numClasses = 9; layers = [ ... sequenceInputLayer(inputSize) lstmLayer(numHiddenUnits,'OutputMode','last') fullyConnectedLayer(numClasses) softmaxLayer classificationLayer]

layers =

5x1 Layer array with layers:

1 '' Sequence Input Sequence input with 12 dimensions

2 '' LSTM LSTM with 100 hidden units

3 '' Fully Connected 9 fully connected layer

4 '' Softmax softmax

5 '' Classification Output crossentropyex

Задайте опции обучения. Задайте решатель как 'adam' и 'GradientThreshold' как 1. Установите мини-пакетный размер на 27 и определите максимальный номер эпох к 100.

Поскольку мини-пакеты малы с короткими последовательностями, центральный процессор лучше подходит для обучения. Установите 'ExecutionEnvironment' к 'cpu'. Чтобы обучаться на графическом процессоре, при наличии, устанавливает 'ExecutionEnvironment' к 'auto' (значение по умолчанию).

maxEpochs = 100; miniBatchSize = 27; options = trainingOptions('adam', ... 'ExecutionEnvironment','cpu', ... 'MaxEpochs',maxEpochs, ... 'MiniBatchSize',miniBatchSize, ... 'GradientThreshold',1, ... 'Verbose',false, ... 'Plots','training-progress');

Обучите сеть LSTM с заданными опциями обучения.

net = trainNetwork(XTrain,YTrain,layers,options);

Загрузите набор тестов и классифицируйте последовательности в динамики.

[XTest,YTest] = japaneseVowelsTestData;

Классифицируйте тестовые данные. Задайте тот же мини-пакетный размер, используемый в обучении.

YPred = classify(net,XTest,'MiniBatchSize',miniBatchSize);Вычислите точность классификации прогнозов.

acc = sum(YPred == YTest)./numel(YTest)

acc = 0.9486

Чтобы создать сеть LSTM для классификации последовательностей к метке, создайте массив слоя, содержащий входной слой последовательности, слой LSTM, полносвязный слой, softmax слой и классификацию выходной слой.

Установите размер входного слоя последовательности к количеству функций входных данных. Установите размер полносвязного слоя к количеству классов. Вы не должны задавать длину последовательности.

Для слоя LSTM задайте количество скрытых модулей и режима вывода 'last'.

numFeatures = 12; numHiddenUnits = 100; numClasses = 9; layers = [ ... sequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits,'OutputMode','last') fullyConnectedLayer(numClasses) softmaxLayer classificationLayer];

Для примера, показывающего, как обучить сеть LSTM для классификации последовательностей к метке и классифицировать новые данные, смотрите, что Классификация Последовательностей Использует Глубокое обучение.

Чтобы создать сеть LSTM для классификации от последовательности к последовательности, используйте ту же архитектуру что касается классификации последовательностей к метке, но установите режим вывода слоя LSTM к 'sequence'.

numFeatures = 12; numHiddenUnits = 100; numClasses = 9; layers = [ ... sequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits,'OutputMode','sequence') fullyConnectedLayer(numClasses) softmaxLayer classificationLayer];

Чтобы создать сеть LSTM для sequence-one регрессии, создайте массив слоя, содержащий входной слой последовательности, слой LSTM, полносвязный слой и регрессию выходной слой.

Установите размер входного слоя последовательности к количеству функций входных данных. Установите размер полносвязного слоя к количеству ответов. Вы не должны задавать длину последовательности.

Для слоя LSTM задайте количество скрытых модулей и режима вывода 'last'.

numFeatures = 12; numHiddenUnits = 125; numResponses = 1; layers = [ ... sequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits,'OutputMode','last') fullyConnectedLayer(numResponses) regressionLayer];

Чтобы создать сеть LSTM для регрессии от последовательности к последовательности, используйте ту же архитектуру что касается sequence-one регрессии, но установите режим вывода слоя LSTM к 'sequence'.

numFeatures = 12; numHiddenUnits = 125; numResponses = 1; layers = [ ... sequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits,'OutputMode','sequence') fullyConnectedLayer(numResponses) regressionLayer];

Для примера, показывающего, как обучить сеть LSTM для регрессии от последовательности к последовательности и предсказать на новых данных, смотрите, что Регрессия От последовательности к последовательности Использует Глубокое обучение.

Можно сделать сети LSTM глубже путем вставки дополнительных слоев LSTM с режимом вывода 'sequence' перед слоем LSTM. Чтобы предотвратить сверхподбор кривой, можно вставить слои уволенного после слоев LSTM.

Для сетей классификации последовательностей к метке режимом вывода последнего слоя LSTM должен быть 'last'.

numFeatures = 12; numHiddenUnits1 = 125; numHiddenUnits2 = 100; numClasses = 9; layers = [ ... sequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits1,'OutputMode','sequence') dropoutLayer(0.2) lstmLayer(numHiddenUnits2,'OutputMode','last') dropoutLayer(0.2) fullyConnectedLayer(numClasses) softmaxLayer classificationLayer];

Для сетей классификации от последовательности к последовательности режимом вывода последнего слоя LSTM должен быть 'sequence'.

numFeatures = 12; numHiddenUnits1 = 125; numHiddenUnits2 = 100; numClasses = 9; layers = [ ... sequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits1,'OutputMode','sequence') dropoutLayer(0.2) lstmLayer(numHiddenUnits2,'OutputMode','sequence') dropoutLayer(0.2) fullyConnectedLayer(numClasses) softmaxLayer classificationLayer];

Слой LSTM изучает долгосрочные зависимости между временными шагами в данных о последовательности и временных рядах.

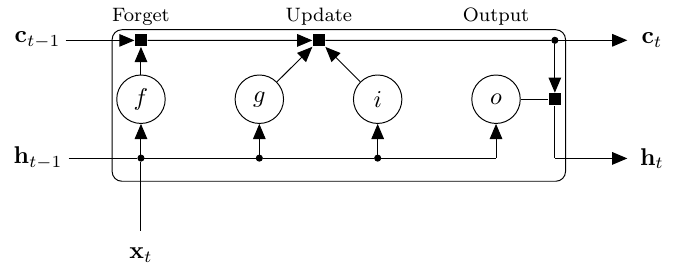

Состояние слоя состоит из скрытого состояния (также известный как состояние вывода) и состояния ячейки. Скрытое состояние на временном шаге t содержит выход слоя LSTM для этого временного шага. Состояние ячейки содержит информацию, усвоенную из предыдущих временных шагов. На каждом временном шаге слой добавляет информацию в или удаляет информацию из состояния ячейки. Слой управляет этими обновлениями с помощью логических элементов.

Следующие компоненты управляют ячейкой и скрытое состояние состояния слоя.

| Компонент | Цель |

|---|---|

| Введите логический элемент (i) | Управляйте уровнем обновления состояния ячейки |

| Забудьте логический элемент (f) | Уровень управления сброса состояния ячейки (забывает) |

| Кандидат ячейки (g) | Добавьте информацию в состояние ячейки |

| Выведите логический элемент (o) | Управляйте уровнем состояния ячейки, добавленного к скрытому состоянию |

Эта схема иллюстрирует поток данных на временном шаге t. Подсветки схемы, как логические элементы забывают, обновляются и выводят ячейку и скрытые состояния.

learnable веса слоя LSTM являются входными весами W (InputWeights), текущие веса R (RecurrentWeights), и смещение b (Bias). Матрицы W, R и b являются конкатенациями входных весов, текущих весов и смещения каждого компонента, соответственно. Эти матрицы конкатенированы можно следующим образом:

где i, f, g и o обозначают входной логический элемент, забывают логический элемент, кандидата ячейки, и выводят логический элемент, соответственно.

Состоянием ячейки на временном шаге t дают

где обозначает продукт Адамара (поэлементное умножение векторов).

Скрытым состоянием на временном шаге t дают

где обозначает функцию активации состояния. lstmLayer функция, по умолчанию, использует гиперболическую функцию тангенса (tanh), чтобы вычислить функцию активации состояния.

Следующие формулы описывают компоненты на временном шаге t.

| Компонент | Формула |

|---|---|

| Введите логический элемент | |

| Забудьте логический элемент | |

| Кандидат ячейки | |

| Выведите логический элемент |

В этих вычислениях, обозначает функцию активации логического элемента. lstmLayer функция, по умолчанию, использует сигмоидальную функцию, данную вычислить функцию активации логического элемента.

Поведение изменяется в R2019a

Начиная в R2019a, программное обеспечение, по умолчанию, инициализирует входные веса слоя этого слоя с помощью инициализатора Glorot. Это поведение помогает стабилизировать обучение и обычно уменьшает учебное время глубоких сетей.

В предыдущих релизах программное обеспечение, по умолчанию, инициализирует входные веса слоя с помощью путем выборки от нормального распределения с нулевым средним значением и отклонением 0.01. Чтобы воспроизвести это поведение, установите 'InputWeightsInitializer' опция слоя к 'narrow-normal'.

Поведение изменяется в R2019a

Начиная в R2019a, программное обеспечение, по умолчанию, инициализирует слой текущие веса этого слоя с Q, ортогональная матрица, данная разложением QR Z = Q R для случайного матричного Z, произведенного от модульного нормального распределения. Это поведение помогает стабилизировать обучение и обычно уменьшает учебное время глубоких сетей.

В предыдущих релизах программное обеспечение, по умолчанию, инициализирует слой текущие веса с помощью путем выборки от нормального распределения с нулевым средним значением и отклонением 0.01. Чтобы воспроизвести это поведение, установите 'RecurrentWeightsInitializer' опция слоя к 'narrow-normal'.

[1] М. Кудо, J. Тояма, и М. Шимбо. "Многомерная Классификация Кривых Используя Прохождение через области". Буквы Распознавания образов. Издание 20, № 11-13, страницы 1103-1111.

[2] Репозиторий Машинного обучения UCI: японский Набор данных Гласных. https://archive.ics.uci.edu/ml/datasets/Japanese+Vowels

[3] Hochreiter, S, и Дж. Шмидхубер, 1997. Долгая краткосрочная память. Нейронный расчет, 9 (8), pp.1735–1780.

[4] Glorot, Ксавьер и Иосуа Бенхио. "Изучая трудность учебных глубоких нейронных сетей feedforward". В Продолжениях тринадцатой международной конференции по вопросам искусственного интеллекта и статистики, стр 249-256. 2010.

[5] Он, Kaiming, Сянюй Чжан, Шаоцин Жэнь и Цзянь Сунь. "Копаясь глубоко в выпрямителях: Превосходная производительность человеческого уровня на imagenet классификации". В Продолжениях международной конференции IEEE по вопросам компьютерного зрения, стр 1026-1034. 2015.

[6] Saxe, Эндрю М., Джеймс Л. Макклеллэнд и Сурья Гэнгули. "Точные решения нелинейной динамики изучения в глубоких линейных нейронных сетях". arXiv предварительно распечатывают arXiv:1312.6120 (2013).

Указания и ограничения по применению:

Для генерации кода, StateActivationFunction свойство должно быть установлено в 'tanh'.

Для генерации кода, GateActivationFunction свойство должно быть установлено в 'sigmoid'.

bilstmLayer | classifyAndUpdateState | flattenLayer | predictAndUpdateState | resetState | sequenceFoldingLayer | sequenceInputLayer | sequenceUnfoldingLayer

У вас есть модифицированная версия этого примера. Вы хотите открыть этот пример со своими редактированиями?

1. Если смысл перевода понятен, то лучше оставьте как есть и не придирайтесь к словам, синонимам и тому подобному. О вкусах не спорим.

2. Не дополняйте перевод комментариями “от себя”. В исправлении не должно появляться дополнительных смыслов и комментариев, отсутствующих в оригинале. Такие правки не получится интегрировать в алгоритме автоматического перевода.

3. Сохраняйте структуру оригинального текста - например, не разбивайте одно предложение на два.

4. Не имеет смысла однотипное исправление перевода какого-то термина во всех предложениях. Исправляйте только в одном месте. Когда Вашу правку одобрят, это исправление будет алгоритмически распространено и на другие части документации.

5. По иным вопросам, например если надо исправить заблокированное для перевода слово, обратитесь к редакторам через форму технической поддержки.