В программном обеспечении Ampilation Learning Toolbox™ предусмотрено несколько предварительно определенных сред grid world, для которых уже определены действия, наблюдения, вознаграждения и динамика. Эти среды можно использовать для:

Изучите концепции обучения усилению.

Познакомьтесь с функциями ПО для обучения по усилению.

Протестируйте собственные агенты обучения усилению.

Следующие предварительно определенные среды MATLAB ® grid world можно загрузить с помощью rlPredefinedEnv функция.

| Окружающая среда | Задача агента |

|---|---|

| Базовый сеточный мир | Перемещение из начального положения в целевое на двумерной сетке путем выбора перемещений из пространства дискретных действий {N,S,E,W}. |

| Мир сети водопадов | Перемещение из начального положения в целевое на более крупной двумерной сетке с неизвестной детерминированной или стохастической динамикой. |

Дополнительные сведения о свойствах сред grid world см. в разделе Создание пользовательских сред Grid World.

Также можно загрузить предварительно определенные среды системы управления MATLAB. Дополнительные сведения см. в разделе Загрузка предварительно определенных сред системы управления.

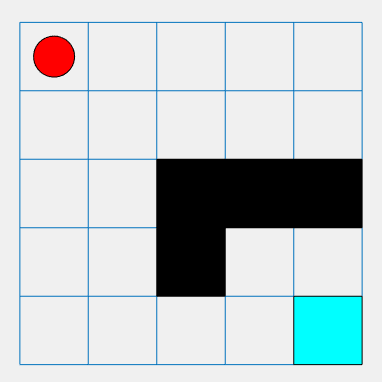

Базовая сетка мира представляет собой двумерную сетку 5 на 5 с начальным местоположением, местом расположения терминала и препятствиями. Среда также содержит специальный переход из состояния [2,4] в состояние [4,4]. Целью агента является перемещение из начального местоположения в конечное, избегая при этом препятствий и максимизируя общее вознаграждение.

Для создания базовой сетевой мировой среды используйте rlPredefinedEnv функция. Эта функция создает rlMDPEnv объект, представляющий мир сетки.

env = rlPredefinedEnv('BasicGridWorld');Среду grid world можно визуализировать с помощью plot функция.

Местоположение агента - красный круг. По умолчанию агент запускается в состоянии [1,1].

Местоположение терминала - синий квадрат.

Препятствия - это черные квадраты.

plot(env)

Агент может двигаться в одном из четырех возможных направлений (север, юг, восток или запад).

Агент получает следующие вознаграждения или штрафы:

+10 вознаграждение за достижение конечного состояния в [5,5]

+5 вознаграждение за прыжок из состояния [2,4] в состояние [4,4]

-1 штраф за любое другое действие

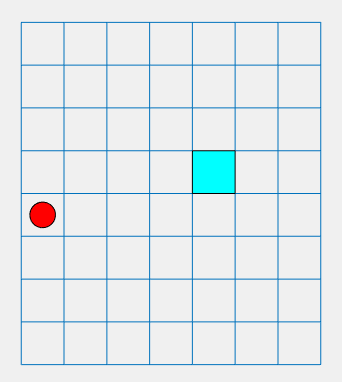

Детерминированная сетка водопада представляет собой двумерную сетку 8 на 7 с начальным и конечным местоположением. Окружающая среда включает водопад, который толкает агент к дну сетки. Целью агента является перемещение из начального местоположения в местоположение терминала с максимизацией общего вознаграждения.

Чтобы создать детерминированный мир сетки водопада, используйте rlPredefinedEnv функция. Эта функция создает rlMDPEnv объект, представляющий мир сетки.

env = rlPredefinedEnv('WaterFallGridWorld-Deterministic');Как и в случае с базовой сеткой, можно визуализировать среду, где агент представляет собой красный круг, а местоположение терминала - синий квадрат.

plot(env)

Агент может двигаться в одном из четырех возможных направлений (север, юг, восток или запад).

Агент получает следующие вознаграждения или штрафы:

+10 вознаграждение за достижение конечного состояния в [4,5]

-1 штраф за любое другое действие

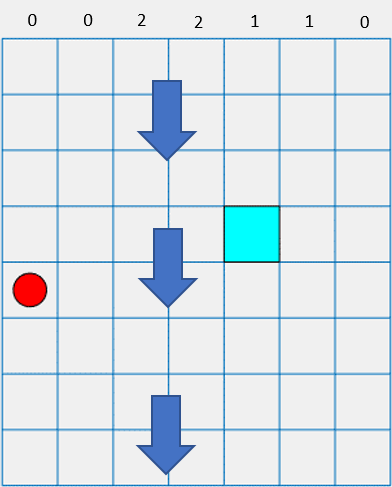

В этой среде водопад толкает агент к дну сетки.

Интенсивность водопада варьируется между колоннами, как показано в верхней части предыдущего рисунка. При движении агента в колонну с ненулевой интенсивностью водопад толкает его вниз на указанное количество квадратов. Например, если агент идет на восток из состояния [5,2], он достигает состояния [7,3].

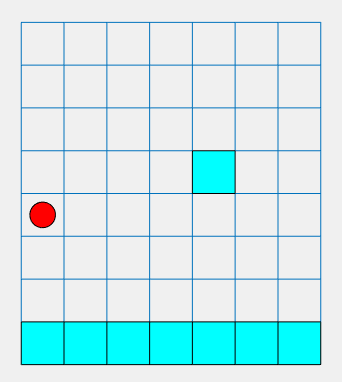

Стохастическая сетка водопада представляет собой двумерную сетку 8 на 7 с начальным местоположением и конечным местоположением. Окружающая среда включает водопад, который толкает агент к дну сетки со стохастической интенсивностью. Целью агента является перемещение из начального местоположения в целевое местоположение терминала, избегая при этом состояний штрафного терминала по нижней части сетки и максимизируя общее вознаграждение.

Чтобы создать стохастическую сетку водопада, используйте rlPredefinedEnv функция. Эта функция создает rlMDPEnv объект, представляющий мир сетки.

env = rlPredefinedEnv('WaterFallGridWorld-Stochastic');Как и в случае с базовой сеткой, можно визуализировать среду, где агент представляет собой красный круг, а местоположение терминала - синий квадрат.

plot(env)

Агент может двигаться в одном из четырех возможных направлений (север, юг, восток или запад).

Агент получает следующие вознаграждения или штрафы:

+10 вознаграждение за достижение конечного состояния в [4,5]

-10 штраф за достижение любого конечного состояния в нижнем ряду сетки

-1 штраф за любое другое действие

В этой среде водопад толкает агент к дну сетки со стохастической интенсивностью. Базовая интенсивность соответствует интенсивности детерминированной среды водопада. Однако в случае стохастического водопада агент имеет равные шансы испытать указанную интенсивность, один уровень выше этой интенсивности или один уровень ниже этой интенсивности. Например, если агент идет на восток от состояния [5,2], он имеет равные шансы достичь состояния [6,3], [7,3] или [8,3].

rlMDPEnv | rlPredefinedEnv | train