Поддержки приложений Reinforcement Learning Designer следующие типы агентов.

Чтобы обучить агента с помощью Reinforcement Learning Designer, необходимо сначала создать или импортировать среду. Для получения дополнительной информации смотрите, Создают Среды MATLAB для Reinforcement Learning Designer и Создают окружения Simulink для Reinforcement Learning Designer.

Чтобы создать агента, на вкладке Reinforcement Learning, в разделе Agent, нажимают New.

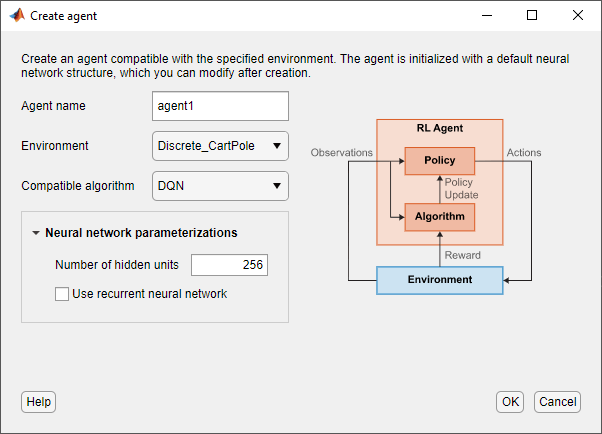

В Создать диалоговом окне агента укажите следующую информацию.

Agent name — Задайте имя своего агента.

Среда Выберите среду, которую вы ранее создали или импортировали.

Compatible algorithm — Выберите алгоритм настройки агента. Этот список содержит только алгоритмы, которые совместимы со средой, которую вы выбираете.

Приложение Reinforcement Learning Designer создает агентов с представлениями актёра и критика глубокой нейронной сети по умолчанию. Можно задать следующие опции для сетей по умолчанию.

Number of hidden units — Задайте количество модулей в каждом полностью соединенном или слой LSTM сетей критика и агента.

Use recurrent neural network — Выберите эту опцию, чтобы создать представления актёра и критика с рекуррентными нейронными сетями, которые содержат слой LSTM.

Чтобы создать агента, нажмите OK.

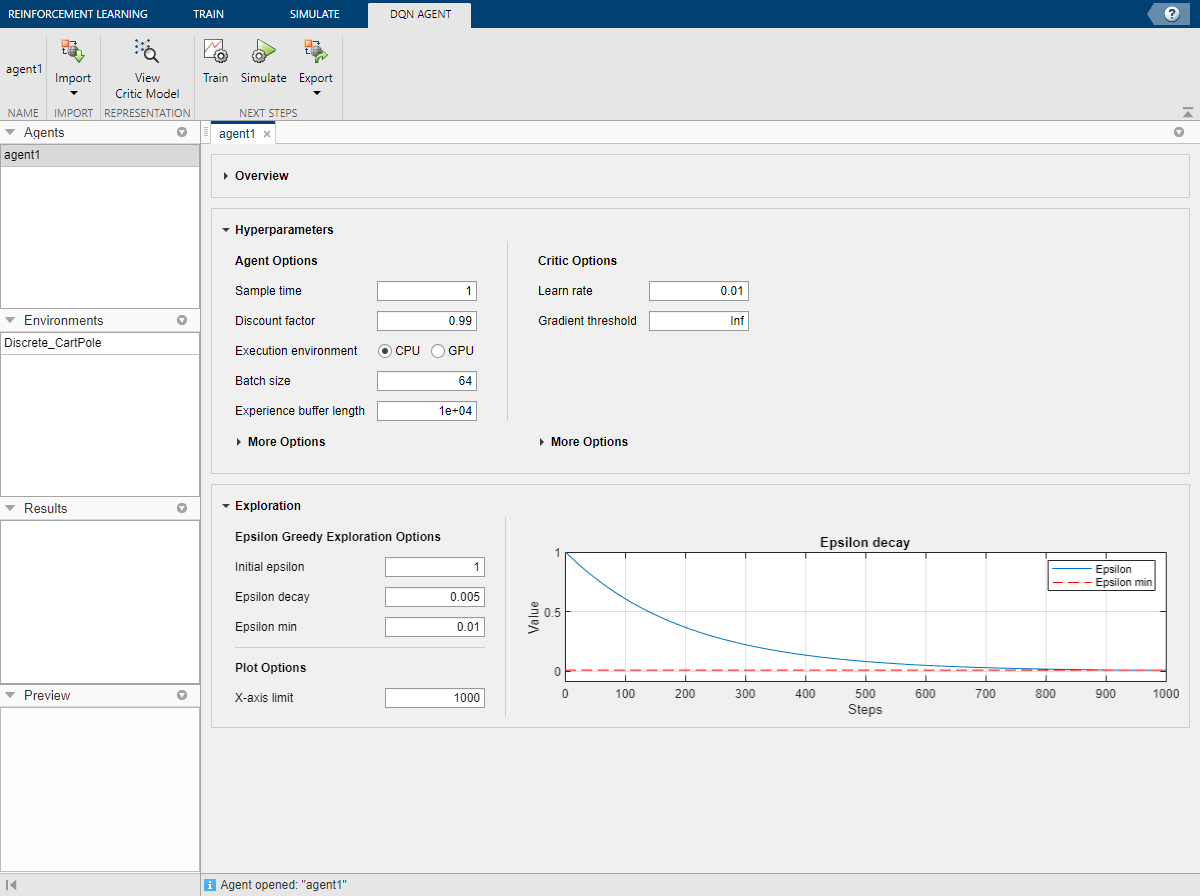

Приложение добавляет, что новый агент по умолчанию к Agents разделяет на области, и открывает документ для редактирования опций агента.

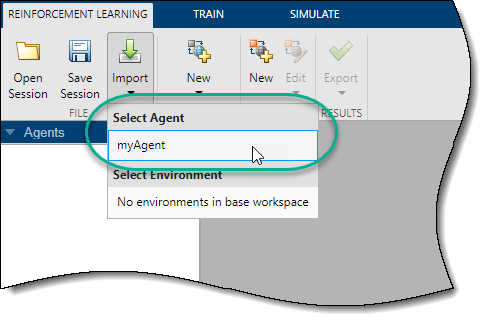

Можно также импортировать агента из MATLAB® рабочая область в Reinforcement Learning Designer. Для этого на вкладке Reinforcement Learning, нажмите Import. Затем под Select Agent выберите агента, чтобы импортировать.

Приложение добавляет, что новый импортированный агент к Agents разделяет на области, и открывает документ для редактирования опций агента.

В Reinforcement Learning Designer можно отредактировать опции агента в соответствующем документе агента.

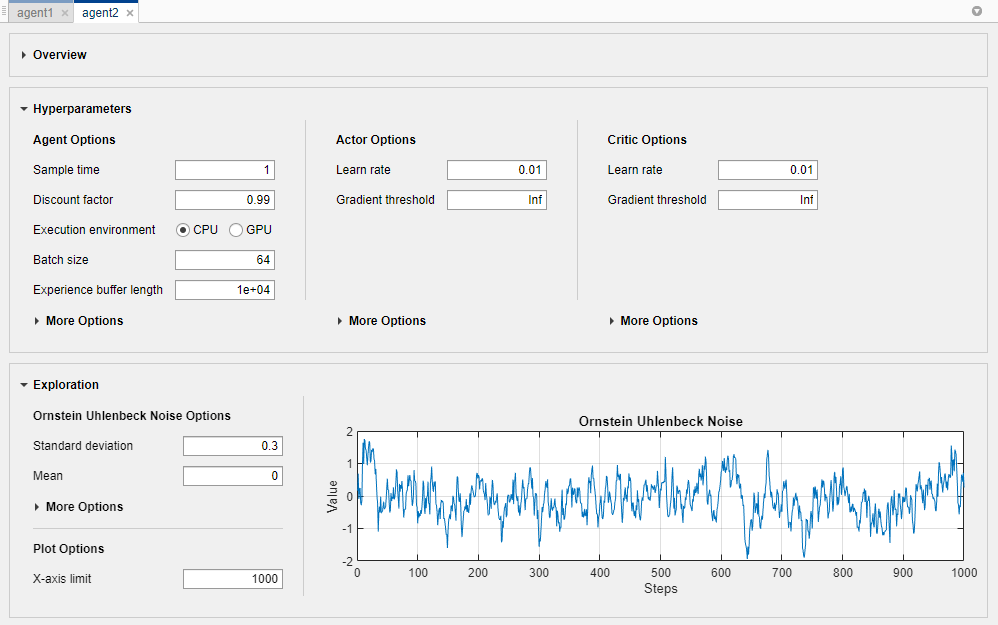

Можно отредактировать следующие опции для каждого агента.

Agent Options — Опции агента, такие как шаг расчета и коэффициент дисконтирования. Задайте эти опции для всех поддерживаемых типов агента.

Опции модели Exploration Model — Exploration. Агенты PPO не имеют модели исследования.

Target Policy Smoothing Model — Опции для целевого сглаживания политики, которое поддерживается только для агентов TD3.

Для получения дополнительной информации об этих опциях смотрите соответствующий объект опций агента.

rlDQNAgentOptions — Опции агента DQN

rlDDPGAgentOptions — Опции агента DDPG

rlTD3AgentOptions — Опции агента TD3

rlPPOAgentOptions — Опции агента PPO

Можно импортировать опции агента из рабочего пространства MATLAB. Чтобы создать опции для каждого типа агента, используйте один из предыдущих объектов. Вы можете также настройки импорта, которые вы ранее экспортировали из приложения Reinforcement Learning Designer

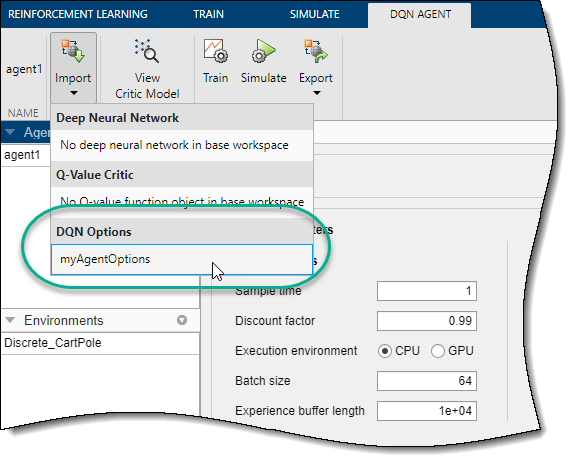

Чтобы импортировать опции, на соответствующей вкладке Agent, нажимают Import. Затем под Options выберите объект опций. Списки приложений только совместимые опции возражают от рабочего пространства MATLAB.

Приложение конфигурирует опции агента, чтобы совпадать с теми В выбранном объекте опций.

Можно отредактировать свойства представлений актёра и критика для каждого агента.

Агенты DQN имеют только сеть критика.

DDPG и агенты PPO имеют представление актера и представление критика.

Агенты TD3 имеют представление актера и два представления критика. Когда вы изменяете опции представления критика для агента TD3, изменения применяются к обоим критикам.

Можно также импортировать представления актёра и критика из рабочего пространства MATLAB. Для получения дополнительной информации о создании представлений актёра и критика смотрите, Создают Представления Функции ценности и политика. Можно также импортировать представления, которые вы ранее экспортировали из приложения Reinforcement Learning Designer.

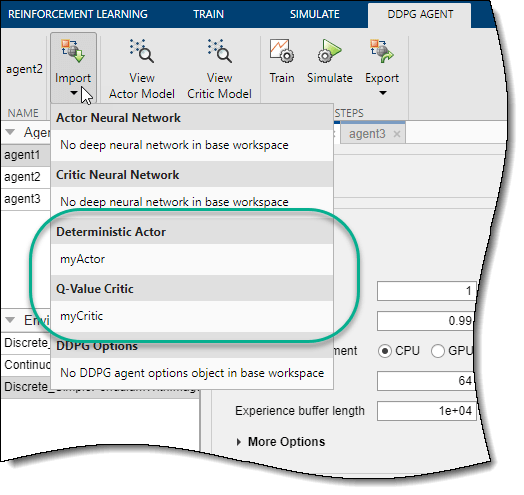

Чтобы импортировать агента или представление критика, на соответствующей вкладке Agent, нажимают Import. Затем или под Actor или под Critic, выберите объект представления с действием и спецификациями наблюдений, которые совместимы с техническими требованиями агента.

Приложение заменяет агента или представление критика в агенте с выбранным представлением. Если вы импортируете представление критика для агента TD3, приложение заменяет сеть для обоих критиков.

Чтобы использовать глубокую нейронную сеть не по умолчанию для агента или критика, необходимо импортировать сеть из рабочего пространства MATLAB. Одна общая стратегия состоит в том, чтобы экспортировать глубокую нейронную сеть по умолчанию, изменить ее с помощью приложения Deep Network Designer, и затем импортировать ее назад в Reinforcement Learning Designer. Для получения дополнительной информации о создании глубоких нейронных сетей для агентов и критиков, смотрите, Создают Представления Функции ценности и политика.

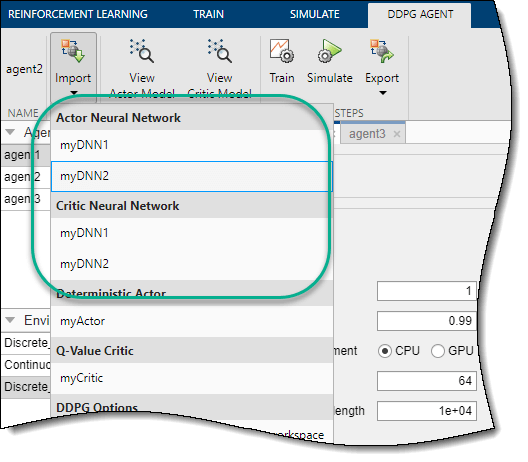

Чтобы импортировать глубокую нейронную сеть, на соответствующей вкладке Agent, нажимают Import. Затем или под Actor Neural Network или под Critic Neural Network, выберите сеть с входными и выходными слоями, которые совместимы со спецификациями наблюдений и спецификациями действия агента.

Приложение заменяет глубокую нейронную сеть в соответствующем агенте или представлении агента. Если вы импортируете сеть критика для агента TD3, приложение заменяет сеть для обоих критиков.

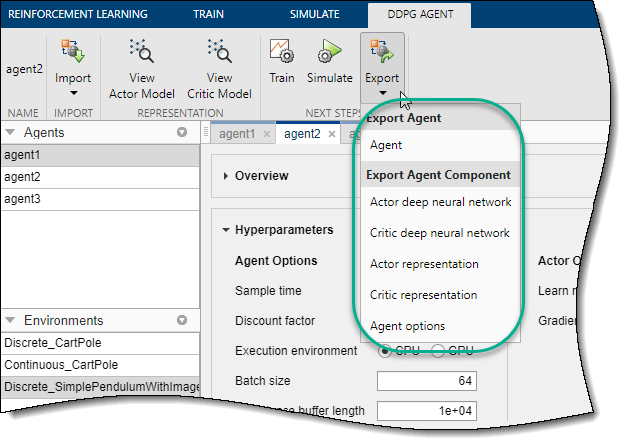

Для данного агента можно экспортировать любое из следующих к рабочему пространству MATLAB.

Агент

Опции агента

Агент или представление критика

Агент или глубокая нейронная сеть критика

Чтобы экспортировать агента или компонент агента, на соответствующей вкладке Agent, нажимают Export. Затем выберите элемент, чтобы экспортировать.

Приложение сохраняет копию агента или компонента агента в рабочем пространстве MATLAB.

Reinforcement Learning Designer | analyzeNetwork