Обнаружьте присутствие речи в звуковом сигнале

voiceActivityDetector Система object™ обнаруживает присутствие речи в аудио сегменте. Можно также использовать voiceActivityDetector Системный объект, чтобы вывести оценку шумового отклонения на интервал частоты.

Обнаружить присутствие речи:

Создайте voiceActivityDetector объект и набор его свойства.

Вызовите объект с аргументами, как будто это была функция.

Чтобы узнать больше, как Системные объекты работают, смотрите то, Что Системные объекты?.

VAD = voiceActivityDetector создает Системный объект, VAD, это обнаруживает присутствие речи независимо через каждый входной канал.

VAD = voiceActivityDetector( наборы каждое свойство Name,Value)Name к заданному Value. Незаданные свойства имеют значения по умолчанию.

VAD = voiceActivityDetector('InputDomain','Frequency') создает Системный объект, VAD, это принимает вход частотного диапазона.[ применяет речевой детектор действия на вход, probability,noiseEstimate]

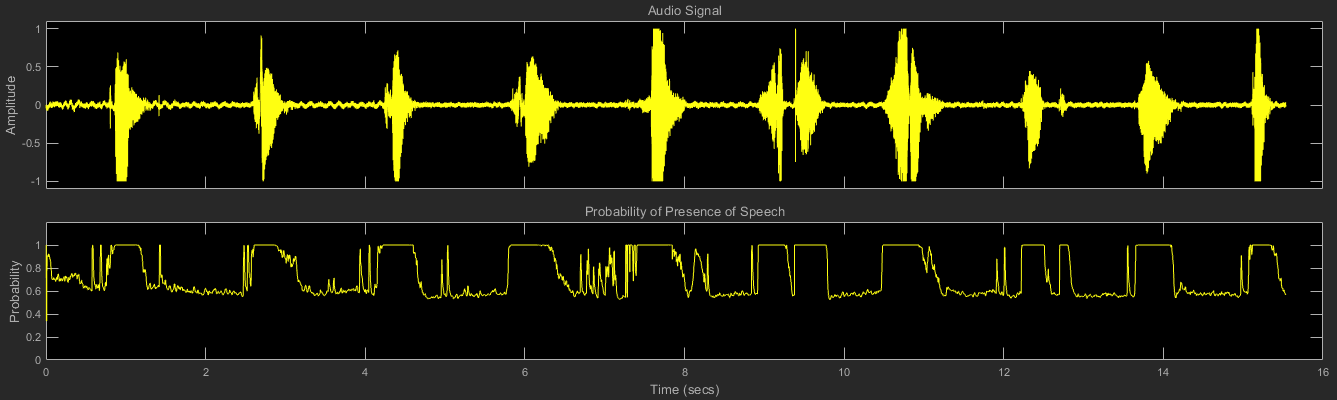

= VAD(audioIn)audioIn, и возвращает вероятность, что речь присутствует. Это также возвращает предполагаемую шумовую дисперсию на интервал частоты.

Чтобы использовать объектную функцию, задайте Системный объект как первый входной параметр. Например, чтобы выпустить системные ресурсы Системного объекта под названием obj, используйте этот синтаксис:

release(obj)

voiceActivityDetector реализует алгоритм, описанный в [1].

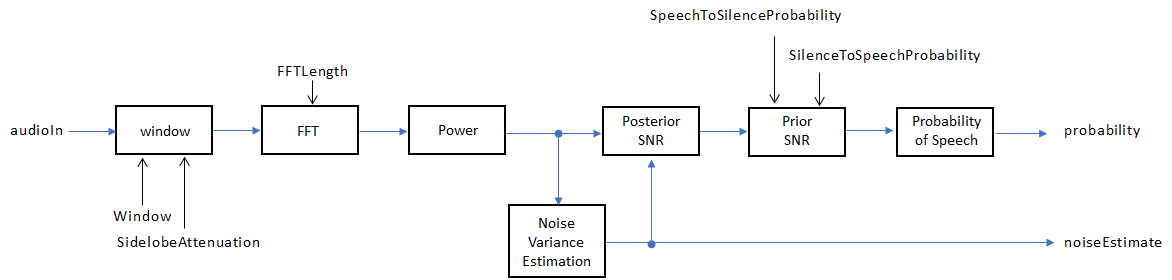

Если InputDomain задан как 'Time', входной сигнал является оконным и затем конвертированным к частотному диапазону согласно Window, SidelobeAttenuation, и FFTLength свойства. Если InputDomain задан как частота, вход принят, чтобы быть оконным преобразованием Фурье дискретного времени (DTFT) звукового сигнала. Сигнал затем преобразован в домен питания. Шумовое отклонение оценивается согласно [2]. Следующий и предшествующий ОСШ оценивается согласно формуле Минимальной среднеквадратичной погрешности (MMSE), описанной в [3]. Логарифмический тест отношения правдоподобия и Скрытая модель Маркова (HMM) - базирующаяся схема похмелья определяет вероятность, что текущая система координат содержит речь, согласно [1].

[1] Зон, Jongseo., Нэм Су Ким и Вонюн Сун. "Статистическое основанное на модели речевое обнаружение действия". Обработка сигналов обозначает буквами IEEE. Издание 6, № 1, 1999.

[2] Мартин, R. "Шумовая Степень Спектральная Оценка Плотности На основе Оптимального Сглаживания и Минимальной Статистики". Транзакции IEEE о Речи и Обработке аудиоданных. Издание 9, № 5, 2001, стр 504–512.

[3] Эфраим, Y. и Д. Мала. "Речевое Улучшение Используя Минимальное Короткое время Среднеквадратичной погрешности Спектральное Амплитудное Средство оценки". Транзакции IEEE на Акустике, Речи и Обработке сигналов. Издание 32, № 6, 1984, стр 1109–1121.

audioFeatureExtractor | cepstralFeatureExtractor | mfcc | pitch | Voice Activity Detector