Усиливающий обучающий агент

Инструментарий для обучения по усилению

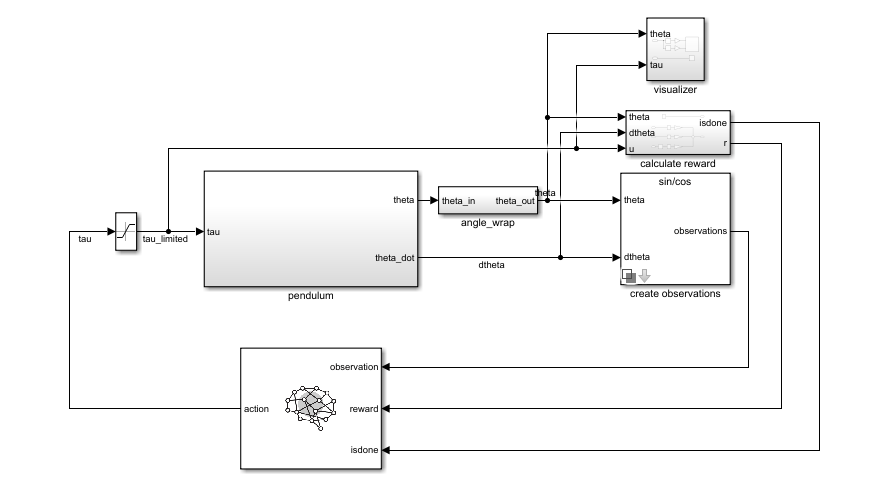

Используйте блок RL Agent для моделирования и обучения агента обучения усилению в Simulink ®. Блок связывается с агентом, хранящимся в рабочей области MATLAB ®, или словарем данных как объект агента, например, rlACAgent или rlDDPGAgent объект. Блок подключается таким образом, что он получает наблюдение и вычисленное вознаграждение. Например, рассмотрим следующую блок-схему rlSimplePendulumModel модель.

observation входной порт блока RL Agent принимает сигнал, получаемый из мгновенного угла и угловой скорости маятника. reward порт получает вознаграждение, рассчитанное из тех же двух значений и примененного действия. Вы настраиваете наблюдения и вычисления вознаграждения, соответствующие вашей системе.

Блок использует агента для создания действия, основанного на наблюдении и вознаграждении, которое вы предоставляете. Подключите action порт вывода на соответствующий вход системы. Например, в rlSimplePendulumModel, action порт - это крутящий момент, приложенный к маятниковой системе. Дополнительные сведения об этой модели см. в разделе Подготовка агента DQN к качанию вверх и балансировке маятника.

Для обучения агента обучения усилению в Simulink создается среда из модели Simulink. Затем создается и настраивается агент для обучения в этой среде. Дополнительные сведения см. в разделе Создание учебных сред усиления Simulink. При звонке train использование среды, train моделирует модель и обновляет агент, связанный с блоком.