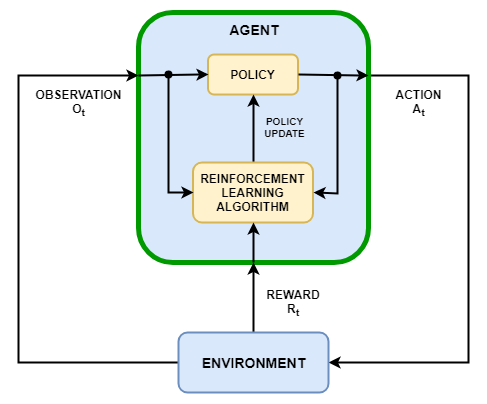

Целью обучения усилению является обучение агента выполнению задачи в неопределенной среде. Агент получает наблюдения и вознаграждение от окружающей среды и отправляет действия в окружающую среду. Награда - это показатель того, насколько успешным является действие в отношении выполнения задачи.

Агент содержит два компонента: политику и алгоритм обучения.

Политика представляет собой сопоставление, которое выбирает действия на основе наблюдений из среды. Обычно политика является аппроксиматором функции с настраиваемыми параметрами, такими как глубокая нейронная сеть.

Алгоритм обучения постоянно обновляет параметры политики на основе действий, наблюдений и вознаграждений. Целью алгоритма обучения является поиск оптимальной политики, которая максимизирует ожидаемое совокупное долгосрочное вознаграждение, полученное во время выполнения задачи.

В зависимости от алгоритма обучения агент поддерживает один или более параметризованных аппроксиматоров функций для обучения политике. Аппроксиматоры могут использоваться двумя способами.

Критики - за данное наблюдение и действие критик возвращает в качестве результата ожидаемое значение кумулятивного долгосрочного вознаграждения за задачу.

Актер - для данного наблюдения актер возвращает в качестве результата действие, которое максимизирует ожидаемое совокупное долгосрочное вознаграждение.

Агенты, которые используют только критиков для выбора своих действий, полагаются на косвенное представление политики. Эти агенты также называются основанными на значении, и они используют аппроксиматор для представления функции значения или функции Q-значения. В общем, эти агенты лучше работают с дискретными пространствами действия, но могут стать вычислительно дорогими для пространств непрерывного действия.

Агенты, которые используют только субъектов для выбора своих действий, полагаются на прямое представление политики. Эти агенты также называются основанными на политике. Политика может быть детерминированной или стохастической. В общем, эти агенты более просты и могут обрабатывать пространства непрерывного действия, хотя обучающий алгоритм может быть чувствительным к шумным измерениям и может сходиться на локальных минимумах.

Агенты, которые используют как актера, так и критика, называются агентами актера-критика. В этих агентах во время обучения актёр осваивает лучшее действие для принятия с помощью обратной связи от критика (вместо использования награды напрямую). При этом критик усваивает ценностную функцию из наград, чтобы она могла должным образом критиковать актёра. В общем, эти агенты могут обрабатывать как дискретные, так и непрерывные пространства действия.

В программном обеспечении Ampilation Learning Toolbox™ предусмотрены следующие встроенные агенты. Эти агенты можно обучить в средах с непрерывными или дискретными пространствами наблюдения и следующими пространствами действий.

В следующих таблицах представлены типы, пространства действий и представления для всех встроенных агентов. Для каждого агента пространство наблюдения может быть дискретным или непрерывным.

Встроенные агенты: тип и пространство действий

| Агент | Напечатать | Пространство действий |

|---|---|---|

| Агенты Q-Learning (Q) | На основе стоимости | Дискретный |

| Агенты Deep Q-Network (DQN) | На основе стоимости | Дискретный |

| Агенты SARSA | На основе стоимости | Дискретный |

| Агенты градиента политики (PG) | На основе политик | Дискретный или непрерывный |

| Актер-критик (AC) | Актёр-критик | Дискретный или непрерывный |

| Агенты оптимизации проксимальной политики (PPO) | Актёр-критик | Дискретный или непрерывный |

| Агенты градиента глубокой детерминированной политики (DDPG) | Актёр-критик | Непрерывный |

| Агенты градиента глубоких детерминированных политик с двойной задержкой (TD3) | Актёр-критик | Непрерывный |

| Мягкий актер-критик (SAC) | Актёр-критик | Непрерывный |

Встроенные агенты: представления, которые необходимо использовать с каждым агентом

| Представление | Q, DQN, SARSA | PG | AC, PPO | МЕШОЧЕК | DDPG, TD3 |

|---|---|---|---|---|---|

Критик функции значения V (S), который создается с помощью | X (если используется базовая линия) | X | |||

Критик Q (S, A) функции Q-value, созданный с помощью | X | X | X | ||

Детерминированный политический субъект δ (S), который создается с помощью | X | ||||

Stochastic policy actor δ (S), который создается с помощью | X | X | X |

Агент с сетями по умолчанию - все агенты, кроме агентов Q-learning и SARSA, поддерживают сети по умолчанию для актеров и критиков. Можно создать агент с представлениями актера и критика по умолчанию на основе спецификаций наблюдения и действий из среды. Для этого в командной строке MATLAB ® выполните следующие действия.

Создайте спецификации наблюдения для среды. Если у вас уже есть объект интерфейса среды, вы можете получить эти спецификации с помощью getObservationInfo.

Создание спецификаций действий для среды. Если у вас уже есть объект интерфейса среды, вы можете получить эти спецификации с помощью getActionInfo.

При необходимости укажите количество нейронов в каждом обучаемом уровне или следует ли использовать уровень LSTM. Для этого создайте объект параметра инициализации агента с помощью rlAgentInitializationOptions.

При необходимости укажите параметры агента, создав набор объектов параметров для конкретного агента.

Создайте агента с помощью соответствующей функции создания агента. Полученный агент содержит соответствующие представления актера и критика, перечисленные в таблице выше. Актер и критик используют специфические для агента глубокие нейронные сети по умолчанию в качестве внутренних аппроксиматоров.

Дополнительные сведения о создании аппроксиматоров функций актера и критика см. в разделе Создание представлений функций политик и значений.

Для импорта существующей среды и интерактивного проектирования агентов DQN, DDPG, PPO или TD3 можно использовать приложение «Дизайнер обучения усиления». Приложение позволяет обучать и моделировать агента в среде, анализировать результаты моделирования, уточнять параметры агента и экспортировать агента в рабочую область MATLAB для дальнейшего использования и развертывания.

При выборе агента рекомендуется начинать с более простого (и быстрого обучения) алгоритма, совместимого с пространствами действий и наблюдений. Затем вы можете попробовать постепенно более сложные алгоритмы, если более простые не работают так, как требуется.

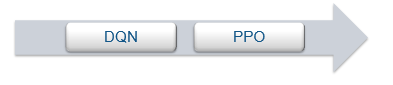

Дискретные пространства действия и наблюдения - для сред с дискретными пространствами действия и наблюдения агент Q-обучения является простейшим совместимым агентом, за которым следуют DQN и PPO.

Пространство дискретного действия и пространство непрерывного наблюдения - для сред с пространством дискретного действия и пространством непрерывного наблюдения DQN является простейшим совместимым агентом, за которым следует PPO.

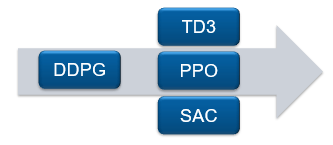

Непрерывное пространство действия - для сред с непрерывным пространством действия и наблюдения DDPG является простейшим совместимым агентом, за которым следуют TD3, PPO и SAC. Для таких сред сначала попробуйте использовать DDPG. В целом:

TD3 является усовершенствованной, более сложной версией DDPG.

PPO имеет более стабильные обновления, но требует дополнительного обучения.

SAC - это усовершенствованная, более сложная версия DDPG, которая генерирует стохастические политики.

Можно также обучить политики, используя другие алгоритмы обучения, создав пользовательский агент. Для этого необходимо создать подкласс пользовательского класса агента и определить поведение агента с помощью набора обязательных и необязательных методов. Дополнительные сведения см. в разделе Создание пользовательских агентов обучения усилению.

rlACAgent | rlDDPGAgent | rlDQNAgent | rlPGAgent | rlPPOAgent | rlQAgent | rlSACAgent | rlSARSAAgent | rlTD3Agent