После обучения классификаторов в Classification Learner можно сравнить модели, основанные на счетах точности, визуализировать результаты путем построения предсказаний классов и проверить эффективность с помощью матрицы неточностей и кривой ROC.

Если вы используете перекрестную валидацию k-fold, то приложение вычисляет счета точности с помощью наблюдений в складках k валидации и сообщает о средней ошибке перекрестной валидации. Это также делает предсказания на наблюдения в этих складках валидации и вычисляет матрицу неточностей и кривую ROC на основе этих предсказаний.

Примечание

Когда вы импортируете данные в приложение, если вы принимаете значения по умолчанию, приложение автоматически использует перекрестную валидацию. Дополнительные сведения см. в разделе Выбор схемы валидации.

Если вы используете валидацию задержки, приложение вычисляет счета точности с помощью наблюдений в валидационной складке и делает предсказания по этим наблюдениям. Приложение также вычисляет матрицу неточностей и кривую ROC на основе этих предсказаний.

Если вы используете валидацию реституции, счет является точностью реституции, основанной на всех обучающих данных, и предсказания являются предсказаниями реституции.

После обучения модели в Classification Learner проверьте панель Models, чтобы увидеть, какая модель имеет лучшую общую точность в процентах. Лучший счет <reservedrangesplaceholder0> подсвечивается в кубе. Этот счет является точностью валидации. Счет точности валидации оценивает эффективность модели по новым данным по сравнению с обучающими данными. Используйте счет, чтобы помочь вам выбрать лучшую модель.

Для перекрестной валидации счет является точностью по всем наблюдениям, считая каждое наблюдение, когда оно находилось в удержанной (валидационной) складке.

Для валидации holdout, счет является точностью на удержанных наблюдениях.

Для валидации реституции, счет является точностью реституции по всем наблюдениям обучающих данных.

Лучший общий счет может быть не лучшей моделью для вашего гола. Модель с немного меньшей общей точностью может быть лучшим классификатором для вашей цели. Для примера, ложные срабатывания в конкретном классе могут быть важны для вас. Вы, возможно, захотите исключить некоторые предикторы, где набор данных является дорогим или трудным.

Чтобы узнать, как классификатор выполнял в каждом классе, исследуйте матрицу неточностей.

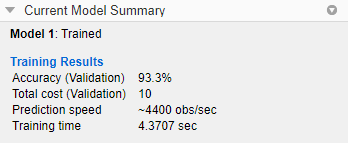

Можно просмотреть метрики модели на панели Current Model Summary и использовать эти метрики для оценки и сравнения моделей. Метрики Training Results вычисляются на наборе валидации. Метрики Test Results, если они отображаются, вычисляются на импортированном тестовом наборе. Для получения дополнительной информации смотрите Оценка производительности модели набора тестов.

Чтобы скопировать информацию на панели Current Model Summary, щелкните правой кнопкой мыши на панели и выберите Copy text.

Метрики модели

| Метрика | Описание | Совет |

|---|---|---|

| Точность | Процент наблюдений, которые правильно классифицированы | Проверьте большие значения точности. |

| Общая стоимость | Общая стоимость неправильной классификации | Найдите меньшие общие значения затрат. Убедитесь, что значение точности все еще велико. |

Можно отсортировать модели на основе различных метрик модели. Чтобы выбрать метрику для сортировки модели, используйте список Sort by в верхней части панели Models.

Можно также удалить нежелательные модели, перечисленные на панели Models. Выберите модель, которую вы хотите удалить, и нажмите кнопку Delete selected model в правом верхнем углу панели или щелкните правой кнопкой мыши модель и выберите Delete model. Вы не можете удалить последнюю оставшуюся модель на панели Models.

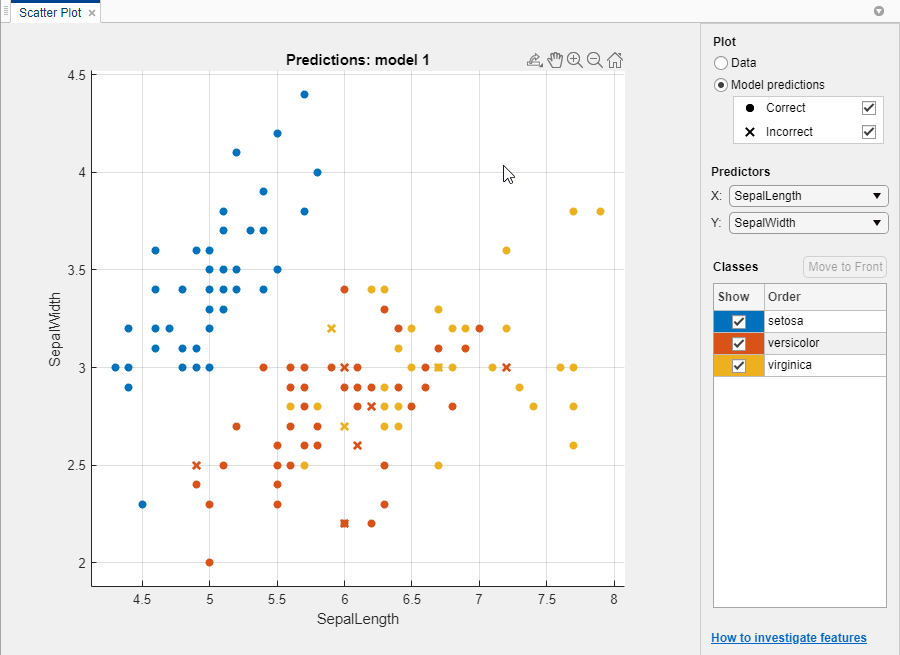

На графике поля точек просмотрите результаты классификатора. После обучения классификатора графика поля точек переключается с отображения данных на отображение предсказаний модели. Если вы используете holdout или перекрестную валидацию, то эти предсказания являются предсказаниями на удержанных (валидационных) наблюдениях. Другими словами, каждое предсказание получается с использованием модели, которая была обучена, не используя соответствующее наблюдение. Чтобы исследовать результаты, используйте элементы управления справа. Вы можете:

Выберите, будет ли строиться график предсказаний модели или только данных.

Показать или скрыть правильные или неправильные результаты можно используя флажки под Model predictions.

Выберите функции для построения графиков с помощью X и Y списков под Predictors.

Визуализируйте результаты по классам, показывая или скрывая определенные классы с помощью флажков под Show.

Измените порядок размещения нанесенных классов, выбрав класс под Classes и нажав Move to Front.

Изменение и изменение масштаба или панорамирование на графике. Чтобы включить масштабирование или панорамирование, наведите указатель мыши на график поля точек и нажмите соответствующую кнопку на панели инструментов, которая находится над верхней частью справа от графика.

Смотрите также Исследуйте Функции в График поля точек.

Чтобы экспортировать графики поля точек, созданные в приложении, в фигуры, смотрите Экспорт Графиков в Classification Learner App.

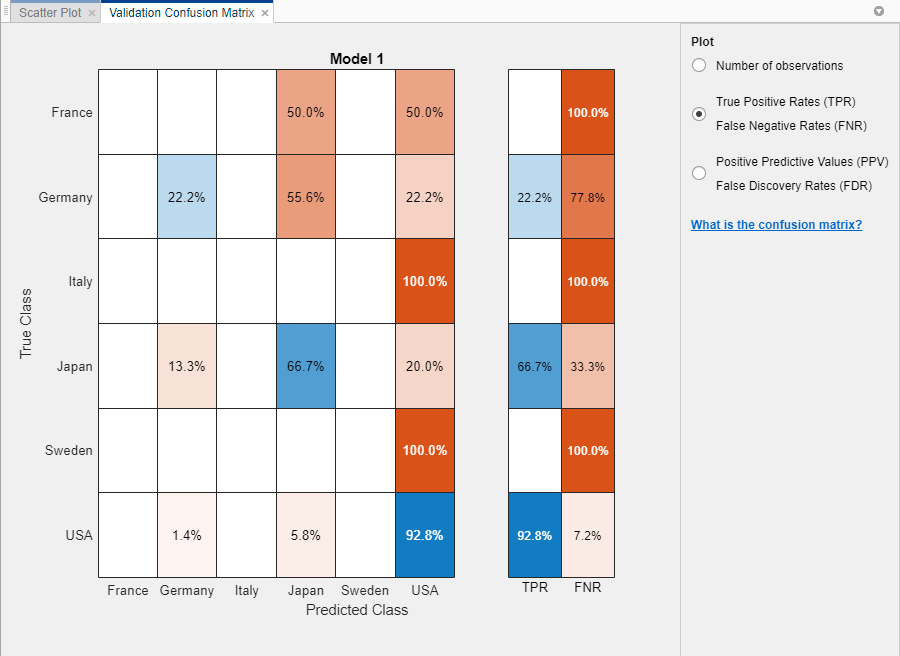

Используйте матричный график неточностей, чтобы понять, как в настоящее время выбранный классификатор выполнялся в каждом классе. Чтобы просмотреть матрицу неточностей после обучения модели, нажмите Confusion Matrix и выберите Validation Data в Plots разделе вкладки Classification Learner. Матрица неточностей помогает вам идентифицировать области, где классификатор выполнял плохо.

Когда вы открываете график, строки показывают истинный класс, а столбцы показывают предсказанный класс. Если вы используете holdout или перекрестную валидацию, то матрица неточностей вычисляется с помощью предсказаний на удержанных (валидационных) наблюдениях. Диагональные камеры показывают, где совпадают истинный класс и предсказанный класс. Если эти диагональные камеры синего цвета, классификатор имеет классифицированные наблюдения этого истинного класса, классифицируются правильно.

Представление по умолчанию показывает количество наблюдений в каждой камере.

Чтобы увидеть, как классификатор выполнялся по классам, в разделе Plot выберите True Positive Rates (TPR) False Negative Rates (FNR) опцию. TPR является долей правильно классифицированных наблюдений на истинный класс. FNR является долей неправильно классифицированных наблюдений на истинный класс. В график показаны сводные данные по true классу в последних двух столбцах справа.

Совет

Проверьте области, где классификатор выполнял плохо, исследуя камеры вне диагонали, которые показывают высокие проценты и являются оранжевыми. Чем выше процент, тем темнее оттенок цвета камеры. В этих оранжевых камерах истинный класс и предсказанный класс не совпадают. Точки данных неправильно классифицируются.

В этом примере, который использует carsmall набор данных, во второй строке сверху показаны все автомобили с истинным классом Германия. В столбцах показаны предсказанные классы. 22,2% автомобилей из Германии классифицированы правильно, поэтому 22.2% истинная положительная ставка для правильно классифицированных точек в этом классе, показанная в синей камере в TPR столбце.

Другие автомобили в строку Германии неправильно классифицируются: 55,6% автомобилей неправильно классифицируются как из Японии, а 22,2% классифицируются как из США. Ложноотрицательная частота для неправильно классифицированных точек в этом классе 77.8%, показана в оранжевой камере в столбце FNR.

Если вы хотите увидеть количество наблюдений (автомобили, в этом примере) вместо процентов, под Plot выберите Number of observations.

Если ложные срабатывания важны в вашей задаче классификации, постройте график результатов по предсказанному классу (вместо истинного класса), чтобы исследовать частоты ложных открытий. Чтобы увидеть результаты по предсказанному классу, в разделе Plot выберите Positive Predictive Values (PPV) False Discovery Rates (FDR) опцию. PPV является долей правильно классифицированных наблюдений на предсказанный класс. FDR является долей неправильно классифицированных наблюдений на предсказанный класс. При выборе этой опции матрица неточностей теперь включает сводные строки под таблицей. Положительные прогнозирующие значения показаны синим цветом для правильно предсказанных точек в каждом классе, а скорости ложных открытий показаны оранжевым цветом для неправильно предсказанных точек в каждом классе.

Если вы решили, что в интересующих классах слишком много неправильно классифицированных точек, попробуйте изменить настройки классификатора или выбор признаков, чтобы найти лучшую модель.

Чтобы экспортировать матричные графики неточностей, созданные в приложении, в рисунки, смотрите Экспорт Графиков в Приложении Classification Learner.

Чтобы просмотреть кривую ROC после обучения модели, на вкладке Classification Learner, в разделе Plots, нажмите ROC Curve и выберите Validation Data. Просмотрите кривую рабочей характеристики приемника (ROC), показывающую истинные и ложноположительные скорости. Кривая ROC показывает истинную положительную скорость по сравнению с ложноположительной частотой для выбранного на данный момент обученного классификатора. Для построения графика можно выбрать различные классы.

Маркер на графике показывает эффективность выбранного классификатора. Маркер показывает значения ложноположительной скорости (FPR) и истинной положительной скорости (TPR) для выбранного классификатора. Для примера ложноположительная частота (FPR) 0,2 указывает, что текущий классификатор неправильно присваивает 20% наблюдений положительному классу. Истинная положительная скорость 0,9 указывает, что текущий классификатор правильно присваивает 90% наблюдений положительному классу.

Идеальным результатом без неправильной классификации точек является правый угол в верхней левой части графика. Плохим результатом, который не лучше случайного, является линия при 45 степенях. Номер Area Under Curve является мерой общего качества классификатора. Большие значения Area Under Curve указывают на лучшую эффективность классификатора. Сравните классы и обученные модели, чтобы увидеть, работают ли они по-разному в кривой ROC.

Для получения дополнительной информации см. perfcurve.

Чтобы экспортировать кривые ROC, созданные в приложении, в рисунки, смотрите Графики экспорта в Приложении Classification Learner.

После обучения модели в Classification Learner можно оценить производительность модели на тестовом наборе в приложении. Этот процесс позволяет вам проверить, обеспечивает ли точность валидации хорошую оценку производительности модели на новых данных.

Импортируйте набор тестовых данных в Classification Learner.

Если набор тестовых данных находится в MATLAB® затем в разделе Testing на вкладке Classification Learner нажмите Test Data и выберите From Workspace.

Если набор тестовых данных находится в файле, то в разделе Testing нажмите Test Data и выберите From File. Выберите тип файла в списке, например, электронную таблицу, текстовый файл или значения, разделенные запятыми (.csv) файл, или выберите All Files, чтобы просмотреть другие типы файлов, такие как .dat.

В диалоговом окне Import Test Data выберите набор тестовых данных из списка Test Data Set Variable. Тестовый набор должен иметь те же переменные, что и предикторы, импортированные для обучения и валидации. Уникальными значениями в переменной тестового отклика должны быть подмножество классов в переменной полного отклика.

Вычислите метрики тестового набора.

Чтобы вычислить тестовые метрики для одной модели, выберите обученную модель на панели Models. На вкладке Classification Learner, в разделе Testing, нажмите Test All и выберите Test Selected.

Чтобы вычислить тестовые метрики для всех обученных моделей, нажмите Test All и выберите Test All в разделе Testing.

Приложение вычисляет эффективность тестового набора каждой модели, обученной на полном наборе данных, включая данные обучения и валидации.

Сравните точность валидации с точностью теста.

На панели Current Model Summary приложение отображает метрики валидации и тестовые метрики в разделе Training Results и Test Results разделе, соответственно. Можно проверить, дает ли точность валидации хорошую оценку точности теста.

Можно также визуализировать результаты тестирования с помощью графиков.

Отобразите матрицу неточностей. В разделе Plots на вкладке Classification Learner нажмите Confusion Matrix и выберите Test Data.

Отображение кривой ROC. В Plots разделе щелкните ROC Curve и выберите Test Data.

Например, смотрите Check Classfier Эффективности Using Test Set in Classification Learner App.Для примера, который использует метрики тестового набора в гипероптимизацию параметров управления рабочем процессе оптимизации, смотрите Train Classfier Using Гипероптимизации параметров управления Optimization in Classification Learner App.