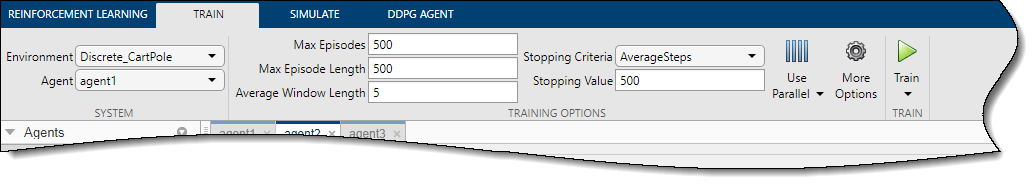

Чтобы сконфигурировать обучение агента в приложении Reinforcement Learning Designer, задайте опции обучения на вкладке Train.

На вкладке Train можно задать следующие опции начальной подготовки.

| Опция | Описание |

|---|---|

| Max Episodes | Максимальное количество эпизодов, чтобы обучить агента в виде положительного целого числа. |

| Max Episode Length | Максимальное количество шагов, чтобы запуститься на эпизод в виде положительного целого числа. |

| Stopping Criteria | Учебное условие завершения в виде одного из следующих значений.

|

| Stopping Value | Критическое значение учебного условия завершения в Stopping Criteria в виде скаляра. |

| Average Window Length | Длина окна для усреднения баллов, вознаграждений и количества шагов для агента, когда или Stopping Criteria или Save agent criteria задают условие усреднения. |

Чтобы задать дополнительные опции обучения, на вкладке Train, нажимают More Options.

В диалоговом окне More Training Options можно задать следующие опции.

| Опция | Описание |

|---|---|

| Save agent criteria | Условие для сохранения агентов во время обучения в виде одного из следующих значений.

|

| Save agent value | Критическое значение условия агента сохранения в Save agent criteria в виде скаляра или "none". |

| Save directory | Папка для сохраненных агентов. Если вы задаете имя, и папка не существует, приложение создает папку в текущей рабочей директории. Чтобы в интерактивном режиме выбрать папку, нажмите Browse. |

| Show verbose output | Выберите эту опцию, чтобы отобразить прогресс обучения в командной строке. |

| Stop on Error | Выберите эту опцию, чтобы остановить обучение, когда ошибка произойдет во время эпизода. |

| Training plot | Опция, чтобы графически отобразить прогресс обучения в приложении в виде одного из следующих значений.

|

Обучать вашего агента с помощью параллельных вычислений, на вкладке Train, нажатии кнопки![]() . Учебные агенты с помощью параллельных вычислений требуют программного обеспечения Parallel Computing Toolbox™. Для получения дополнительной информации смотрите, Обучают Агентов Используя Параллельные вычисления и графические процессоры.

. Учебные агенты с помощью параллельных вычислений требуют программного обеспечения Parallel Computing Toolbox™. Для получения дополнительной информации смотрите, Обучают Агентов Используя Параллельные вычисления и графические процессоры.

Чтобы задать опции для параллельного обучения, выберите Use Parallel> Parallel training options.

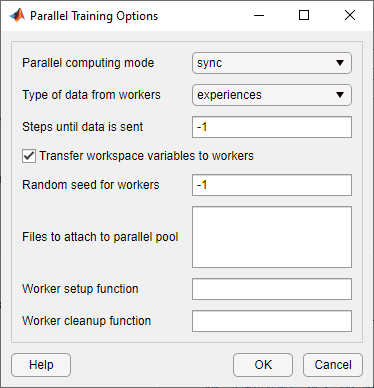

В диалоговом окне Parallel Training Options можно задать следующие опции обучения.

| Опция | Описание |

|---|---|

| Parallel computing mode | Режим параллельных вычислений в виде одного из следующих значений.

|

| Type of data from workers | Тип данных, которые рабочие отправляют параллельному клиенту пула в виде одного из следующих значений.

Примечание Для DQN, DDPG, PPO, SAC и TD3 необходимо установить эту опцию на |

| Steps until data is sent | Количество шагов, после которых рабочие отправляют данные клиенту и получают обновленные параметры в виде |

| Transfer workspace variables to workers | Выберите эту опцию, чтобы отправить переменные и рабочей области модели, чтобы быть параллельными рабочим. Когда вы выбираете эту опцию, параллельный клиент пула (процесс, который запускается, обучение) отправляет переменные, используемые в моделях и заданные в MATLAB® рабочая область рабочим. |

| Random seed for workers | Инициализация Randomizer для рабочих в виде одного из следующих значений.

|

| Files to attach to parallel pool | Дополнительные файлы, чтобы присоединить к параллельному пулу. Задайте имена файлов в текущей рабочей директории с одним именем на каждой линии. |

| Worker setup function | Функция, чтобы запуститься перед обучением запускается в виде указателя на функцию, имеющую входные параметры. Эта функция запущена однажды на рабочего, прежде чем обучение начнется. Запишите эту функцию, чтобы выполнить любую обработку, в которой вы нуждаетесь до обучения. |

| Worker cleanup function | Функция, чтобы выполняться после учебных концов в виде указателя на функцию, имеющую входные параметры. Можно записать эту функцию, чтобы очистить рабочую область или выполнить другую обработку после того, как обучение завершит работу. |

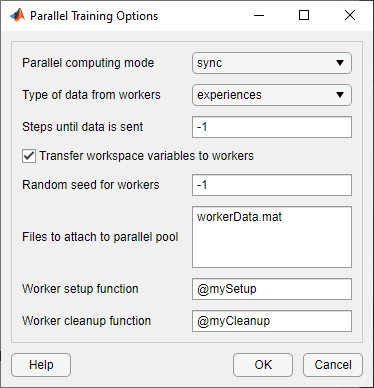

Следующий рисунок показывает, что пример параллелен учебной настройке следующие файлы и функции.

Файл данных, присоединенный к параллельному пулу — workerData.mat

Функция настройки рабочего — mySetup.m

Функция очистки рабочего — myCleanup.m

Reinforcement Learning Designer