Программное обеспечение Reinforcement Learning Toolbox™ обеспечивает несколько предопределенных сред мира сетки, для которых уже заданы действия, наблюдения, вознаграждения и динамика. Можно использовать эти среды для:

Изучите концепции изучения укрепления

Получите знакомство с программными функциями Reinforcement Learning Toolbox

Протестируйте свои собственные агенты изучения укрепления

Можно загрузить следующие предопределенные среды мира сетки MATLAB® с помощью функции rlPredefinedEnv.

| Среда | Задача агента |

|---|---|

| Основной мир сетки | Переместитесь от стартового местоположения до целевого местоположения на двумерной сетке путем выбора перемещений из дискретного пробела действия {N,S,E,W}. |

| Мир сетки водопада | Переместитесь от стартового местоположения до целевого местоположения на большей двумерной сетке с неизвестной детерминированной или стохастической динамикой. |

Для получения дополнительной информации о свойствах сред мира сетки Создайте Пользовательские Среды Мира Сетки.

Можно также загрузить, предопределил среды системы управления MATLAB. Для получения дополнительной информации смотрите Загрузку Предопределенные Среды Системы управления.

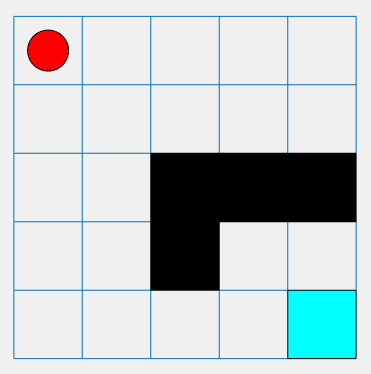

Основная среда мира сетки является двумерной сеткой 5 на 5 со стартовым местоположением, терминальным местоположением и препятствиями. Среда также содержит специальный скачок от состояния [2,4], чтобы утвердить [4,4]. Цель агента состоит в том, чтобы переместиться от стартового местоположения до терминального местоположения при предотвращении препятствий и максимизации общего вознаграждения.

Чтобы создать основную среду мира сетки, используйте функцию rlPredefinedEnv. Эта функция создает объект rlMDPEnv, представляющий мир сетки.

env = rlPredefinedEnv('BasicGridWorld');Можно визуализировать среду мира сетки с помощью функции plot. График отображается:

Местоположение агента как красный круг. По умолчанию агент запускается в состоянии [1,1].

Терминальное местоположение как синий квадрат

Препятствия как черные квадраты

plot(env)

Агент может переместиться в одно из четырех возможных направлений (Север, Юг, Восток, Запад).

Агент получает следующие вознаграждения или штрафы:

Вознаграждение +10 за достижение терминального состояния в [5,5]

Вознаграждение +5 за то, что спрыгнули с состояния [2,4], чтобы утвердить [4,4].

Штраф -1 за любое действие

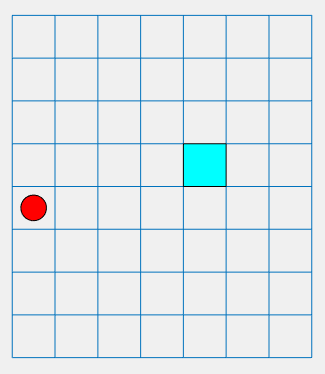

Детерминированная среда мира сетки водопада является двумерным 8 7 сетка со стартовым местоположением и терминальным местоположением. Среда включает водопад, который продвигает агент к нижней части сетки. Цель агента состоит в том, чтобы переместиться от стартового местоположения до терминального местоположения при максимизации общего вознаграждения.

Чтобы создать детерминированный мир сетки водопада, используйте функцию rlPredefinedEnv. Эта функция создает объект rlMDPEnv, представляющий мир сетки.

env = rlPredefinedEnv('WaterFallGridWorld-Deterministic');Как с основным миром сетки, можно визуализировать среду, где агент является красным кругом, и терминальное местоположение является синим квадратом.

plot(env)

Агент может переместиться в одно из четырех возможных направлений (Север, Юг, Восток, Запад).

Агент получает следующие вознаграждения или штрафы:

Вознаграждение +10 за достижение терминального состояния в [4,5]

Штраф -1 за любое действие

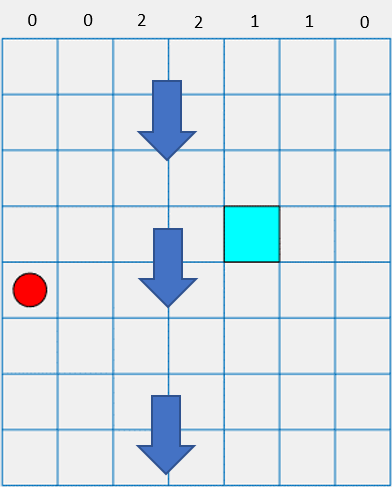

В этой среде водопад продвигает агент к нижней части сетки.

Интенсивность водопада отличается между столбцами, как показано наверху предыдущей фигуры. Когда перемещения агента в столбец с ненулевой интенсивностью, водопад продвигает его вниз обозначенным количеством квадратов. Например, если агент пойдет на восток от состояния [5,2], это достигнет состояния [7,3].

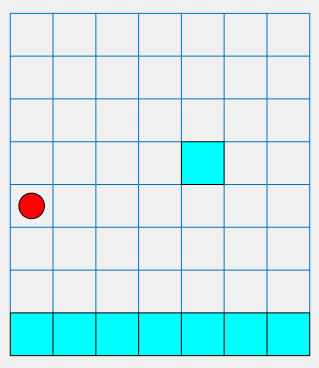

Стохастическая среда мира сетки водопада является двумерным 8 7 сетка со стартовым местоположением и терминальными местоположениями. Среда включает водопад, который продвигает агент к нижней части сетки со стохастической интенсивностью. Цель агента состоит в том, чтобы переместиться от стартового местоположения до целевого терминального местоположения при предотвращении состояний терминала штрафа вдоль нижней части сетки и максимизации общего вознаграждения.

Чтобы создать стохастический мир сетки водопада, используйте функцию rlPredefinedEnv. Эта функция создает объект rlMDPEnv, представляющий мир сетки.

env = rlPredefinedEnv('WaterFallGridWorld-Stochastic');Как с основным миром сетки, можно визуализировать среду, где агент является красным кругом, и терминальное местоположение является синим квадратом.

plot(env)

Агент может переместиться в одно из четырех возможных направлений (Север, Юг, Восток, Запад).

Агент получает следующие вознаграждения или штрафы:

Вознаграждение +100 за достижение терминального состояния в [4,5]

Штраф -10 за достижение любого терминального состояния в нижнем ряду сетки

Штраф -1 за любое действие

В этой среде водопад продвигает агент к нижней части сетки со стохастической интенсивностью. Базовая интенсивность совпадает с интенсивностью детерминированной среды водопада. Однако в стохастическом случае водопада, агент имеет равный шанс испытания или обозначенная интенсивность, один уровень выше той интенсивности или один уровень ниже той интенсивности. Например, если агент идет на восток от состояния [5,2], это имеет равный шанс на достижение или состояние [6,3], [7,3], или [8,3].

rlMDPEnv | rlPredefinedEnv | train