После учебных классификаторов в Classification Learner можно сравнить модели на основе баллов точности, визуализировать результаты путем графического вывода предсказаний класса и проверять эффективность с помощью матрицы беспорядка и кривой ROC.

Если вы используете перекрестную проверку k-сгиба, то приложение вычисляет баллы точности с помощью наблюдений в k валидации, сворачивает и сообщает о средней ошибке перекрестной проверки. Это также делает предсказания на наблюдениях в этих, валидация сворачивает и вычисляет матрицу беспорядка и кривую ROC на основе этих предсказаний.

Примечание

Когда вы импортируете данные в приложение, если вы принимаете значения по умолчанию, приложение автоматически использует перекрестную проверку. Чтобы узнать больше, смотрите, Выбирают Validation Scheme.

Если вы используете валидацию затяжки, приложение вычисляет баллы точности с помощью наблюдений в сгибе валидации и делает предсказания на этих наблюдениях. Приложение также вычисляет матрицу беспорядка и кривую ROC на основе этих предсказаний.

Если вы используете валидацию перезамены, счет является точностью перезамены на основе всех обучающих данных, и предсказания являются предсказаниями перезамены.

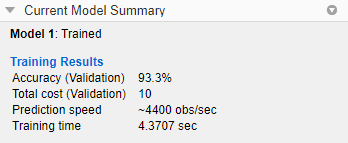

После обучения модель в Classification Learner проверяйте панель Models, чтобы видеть, какая модель имеет лучшую общую точность в проценте. Лучший счет Accuracy (Validation) подсвечен в поле. Этот счет является точностью валидации. Счет точности валидации оценивает эффективность модели на новых данных по сравнению с обучающими данными. Используйте счет, чтобы помочь вам выбрать лучшую модель.

Для перекрестной проверки счет является точностью на всех наблюдениях, считая каждое наблюдение, когда это был в затяжке (валидация) сгиб.

Для валидации затяжки счет является точностью на протянутых наблюдениях.

Для валидации перезамены счет является точностью перезамены против всех наблюдений обучающих данных.

Лучшая общая оценка не может быть лучшей моделью для вашей цели. Модель с немного более низкой общей точностью может быть лучшим классификатором для вашей цели. Например, ложные положительные стороны в конкретном классе могут быть важны для вас. Вы можете хотеть исключить некоторые предикторы, где сбор данных является дорогим или трудным.

Чтобы узнать как классификатор, выполняемый в каждом классе, исследуйте матрицу беспорядка.

Можно просмотреть метрики модели в панели Current Model Summary и использовать эти метрики, чтобы оценить и сравнить модели. Метрики Training Results вычисляются на набор валидации. Метрики Test Results, если отображено, вычисляются на импортированный набор тестов. Для получения дополнительной информации смотрите, Оценивают Производительность модели Набора тестов.

Чтобы скопировать информацию в панели Current Model Summary, щелкните правой кнопкой по панели и выберите Copy text.

Метрики модели

| Метрика | Описание | Совет |

|---|---|---|

| Точность | Процент наблюдений, которые правильно классифицируются | Ищите большие значения точности. |

| Общая стоимость | Общее количество misclassification стоимость | Ищите меньшие значения общей стоимости. Убедитесь, что значение точности является все еще большим. |

Можно отсортировать модели на основе различных метрик модели. Чтобы выбрать метрику для сортировки модели, используйте список Sort by наверху панели Models.

Можно также удалить нежелательные модели, перечисленные в панели Models. Выберите модель, вы хотите удалить и нажать кнопку Delete selected model в верхнем правом углу панели, или щелкнуть правой кнопкой по модели и выбрать Delete model. Вы не можете удалить последнюю остающуюся модель в панели Models.

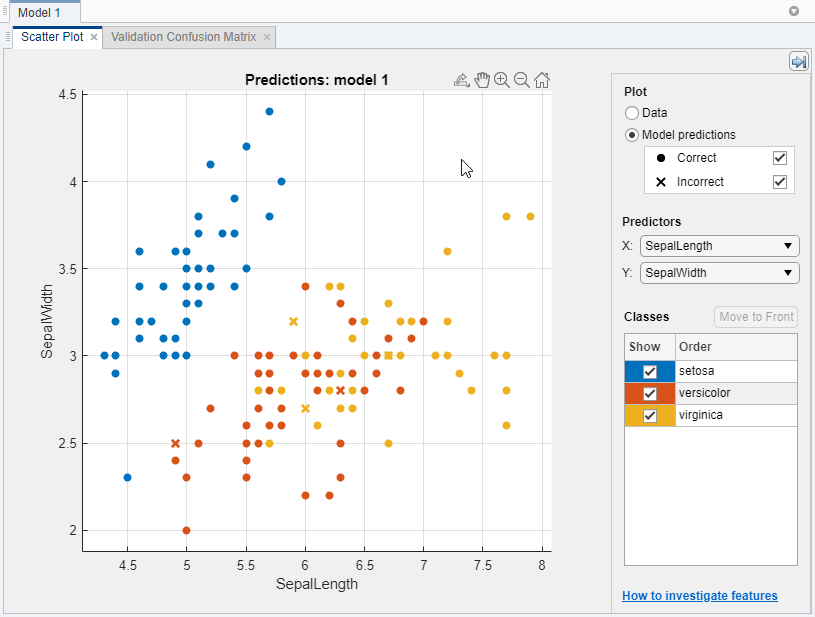

Используйте график рассеивания, чтобы исследовать результаты классификатора. Чтобы просмотреть график рассеивания для модели, выберите модель в панели Models. На вкладке Classification Learner, в разделе Plots, кликают по стреле, чтобы открыть галерею, и затем нажать Scatter в группе Validation Results. После того, как вы обучаете классификатор, переключатели графика рассеивания от отображения данных к показу предсказаний модели. Если вы используете затяжку или перекрестную проверку, то эти предсказания являются предсказаниями на протянутом (валидация) наблюдения. Другими словами, каждое предсказание получено с помощью модели, которая была обучена, не используя соответствующее наблюдение.

Чтобы исследовать ваши результаты, используйте средства управления справа. Вы можете:

Выберите, построить ли предсказания модели или одни только данные.

Покажите или скройте правильные или неправильные результаты с помощью флажков под Model predictions.

Выберите признаки, чтобы построить использование X и списков Y под Predictors.

Визуализируйте результаты классом путем показа или сокрытия определенных классов с помощью флажков под Show.

Измените порядок размещения нанесенных на график классов путем выбора класса под Classes и затем нажатия на Move to Front.

Увеличьте и уменьшите масштаб, или панорамирование через график. Чтобы позволить масштабировать или панорамировать, поместите мышь по графику рассеивания и нажмите соответствующую кнопку на панели инструментов, которая появляется выше правого верхнего из графика.

См. также Исследуют Функции в Графике поля точек.

Чтобы экспортировать графики рассеивания, вы создаете в приложении фигурам, видите Графики Экспорта в Приложении Classification Learner.

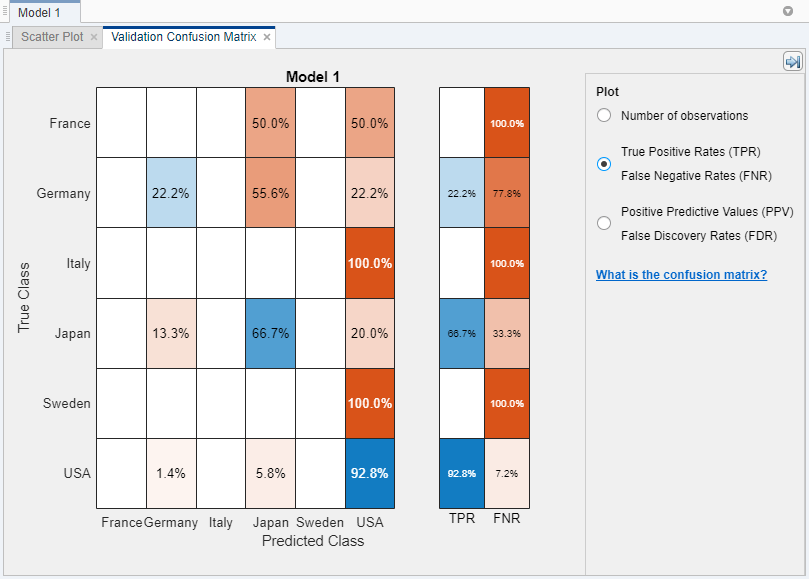

Используйте матричный график беспорядка изучить, как в настоящее время выбранный классификатор выполнил в каждом классе. После того, как вы обучите модель классификации, приложение автоматически открывает матрицу беспорядка для той модели. Если вы обучаете модель "All", приложение открывает матрицу беспорядка для первой модели только. Чтобы просмотреть матрицу беспорядка для другой модели, выберите модель в панели Models. На вкладке Classification Learner, в разделе Plots, кликают по стреле, чтобы открыть галерею, и затем нажать Confusion Matrix (Validation) в группе Validation Results. Матрица беспорядка помогает вам идентифицировать области, где классификатор выполнил плохо.

Когда вы открываете график, строки показывают истинный класс, и столбцы показывают предсказанный класс. Если вы используете затяжку или перекрестную проверку, то матрица беспорядка вычисляется с помощью предсказаний на протянутом (валидация) наблюдения. Диагональные ячейки показывают, где истинный класс и предсказал соответствие класса. Если эти диагональные ячейки являются синими, классификатор классифицировал наблюдения за этим истинным классом правильно.

Представление по умолчанию показывает количество наблюдений в каждой ячейке.

Чтобы видеть, как классификатор, выполняемый в классе, под Plot, выбирает True Positive Rates (TPR), опцию False Negative Rates (FNR). TPR является пропорцией правильно классифицированных наблюдений в истинном классе. FNR является пропорцией неправильно классифицированных наблюдений в истинном классе. График показывает сводные данные в истинном классе в последних двух столбцах справа.

Совет

Ищите области, где классификатор выполнил плохо путем исследования ячеек от диагонали, которые отображают высокие проценты и являются оранжевыми. Чем выше процент, тем более темный оттенок цвета ячейки. В этих оранжевых ячейках не соответствуют истинный класс и предсказанный класс. Точки данных неправильно классифицируются.

В этом примере, который использует carsmall набор данных, вторая строка от верхней части показывает все автомобили с истинным классом Германия. Столбцы показывают предсказанные классы. Из автомобилей из Германии правильно классифицируются 22,2%, таким образом, 22.2% является истинным положительным уровнем для правильно классифицированных точек в этом классе, показанном в синей ячейке в столбце TPR.

Другие автомобили в строке Германии неправильно классифицируются: 55,6% автомобилей неправильно классифицируется как из Японии, и 22,2% классифицируются как из США. Ложным отрицательным уровнем для неправильно классифицированных точек в этом классе является 77.8%, показанный в оранжевой ячейке в столбце FNR.

Если вы хотите видеть, что количества наблюдений (автомобили, в этом примере) вместо процентов, под Plot, выбирают Number of observations.

Если ложные положительные стороны важны в вашей проблеме классификации, строят результаты в предсказанном классе (вместо истинного класса), чтобы исследовать ложные уровни открытия. Чтобы видеть результаты в предсказанном классе, под Plot, выбирают Positive Predictive Values (PPV), опцию False Discovery Rates (FDR). PPV является пропорцией правильно классифицированных наблюдений в предсказанном классе. ФРГ является пропорцией неправильно классифицированных наблюдений в предсказанном классе. С этой выбранной опцией матрица беспорядка теперь включает сводные строки ниже таблицы. Положительные прогнозирующие значения отображают синим для правильно предсказанных точек в каждом классе, и ложные уровни открытия отображают оранжевым для неправильно предсказанных точек в каждом классе.

Если вы решаете, что существует слишком много неправильно классифицированных точек в классах интереса, пытаются изменить настройки классификатора или выбор признаков, чтобы искать лучшую модель.

Чтобы экспортировать матричные графики беспорядка, вы создаете в приложении фигурам, видите Графики Экспорта в Приложении Classification Learner.

Чтобы просмотреть кривую ROC после обучения модель, на вкладке Classification Learner, в разделе Plots, кликают по стреле, чтобы открыть галерею, и затем нажать ROC Curve (Validation) в группе Validation Results. Просмотрите истину и ложь показа кривой рабочей характеристики приемника (ROC) положительные уровни. Кривая ROC показывает истинный положительный уровень по сравнению с ложным положительным уровнем для в настоящее время выбранного обученного классификатора. Можно выбрать различные классы, чтобы построить.

Маркер на графике показывает эффективность в настоящее время выбранного классификатора. Маркер показывает значения ложного положительного уровня (FPR) и истинного положительного уровня (TPR) для в настоящее время выбранного классификатора. Например, ложный положительный уровень (FPR) 0,2 указывает, что текущий классификатор присваивает 20% наблюдений неправильно к положительному классу. Истинный положительный уровень 0,9 указывает, что текущий классификатор присваивает 90% наблюдений правильно к положительному классу.

Совершенным результатом без неправильно классифицированных точек является прямой угол к левому верхнему из графика. Плохим результатом, который является не лучше, чем случайный, является линия в 45 градусах. Номер Area Under Curve является мерой общего качества классификатора. Большие значения Area Under Curve указывают на лучшую эффективность классификатора. Сравните классы и обученные модели, чтобы видеть, выполняют ли они по-другому в кривой ROC.

Для получения дополнительной информации смотрите perfcurve.

Чтобы экспортировать ROC изгибают графики, которые вы создаете в приложении фигурам, видите Графики Экспорта в Приложении Classification Learner.

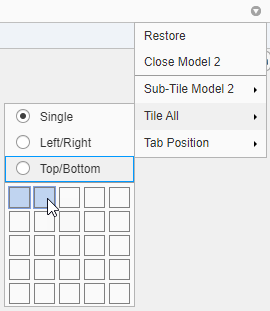

Визуализируйте результаты моделей, обученных в Classification Learner при помощи опций графика в разделе Plots вкладки Classification Learner. Можно перестроить размещение графиков сравнить результаты через многоуровневые модели: используйте опции в кнопке Layout, перетащите мышью графики или выберите возможности, предоставленные стрелой Действий Документа, расположенной справа от вкладок графика модели.

Например, после обучения две модели в Classification Learner, отобразите график для каждой модели и измените размещение графика, чтобы сравнить графики при помощи одной из этих процедур:

Нажмите Layout и выберите Compare models в разделе Plots вкладки Classification Learner.

Кликните по второму имени вкладки модели, и затем перетащите мышью вторую вкладку модели направо.

Кликните по стреле Действий Документа, расположенной справа вкладок графика модели. Выберите Tile All опция и задает 1 2 размещение.

Обратите внимание на то, что можно нажать кнопку опций графика Hide![]() в правых верхних из графиков сделать больше комнаты для графиков.

в правых верхних из графиков сделать больше комнаты для графиков.

После обучения модель в Classification Learner можно оценить производительность модели на наборе тестов в приложении. Этот процесс позволяет вам проверять, обеспечивает ли точность валидации хорошую оценку для производительности модели на новых данных.

Импортируйте набор тестовых данных в Classification Learner.

Если набор тестовых данных находится в MATLAB® рабочая область, затем в разделе Testing по вкладке Classification Learner, нажимает Test Data и выбирает From Workspace.

Если набор тестовых данных находится в файле, то в разделе Testing, нажмите Test Data и выберите From File. Выберите тип файла в списке, таком как электронная таблица, текстовый файл или разделенные от запятой значения (.csv) файл, или выбирают All Files, чтобы просмотреть другие типы файлов, такие как .dat.

В диалоговом окне Import Test Data выберите набор тестовых данных из списка Test Data Set Variable. Набор тестов должен иметь те же переменные как предикторы, импортированные для обучения и валидации. Уникальные значения в тестовой переменной отклика должны быть подмножеством классов в полной переменной отклика.

Вычислите метрики набора тестов.

Чтобы вычислить тестовые метрики для одной модели, выберите обученную модель в панели Models. На вкладке Classification Learner, в разделе Testing, нажимают Test All и выбирают Test Selected.

Чтобы вычислить тестовые метрики для всех обученных моделей, нажмите Test All и выберите Test All в разделе Testing.

Приложение вычисляет эффективность набора тестов каждой модели, обученной на полном наборе данных, включая данные об обучении и валидации.

Сравните точность валидации с тестовой точностью.

В панели Current Model Summary, отображения приложения метрики валидации и тестовые метрики под разделом Training Results и разделом Test Results, соответственно. Можно проверять, дает ли точность валидации хорошую оценку для тестовой точности.

Можно также визуализировать результаты испытаний с помощью графиков.

Отобразите матрицу беспорядка. В разделе Plots по вкладке Classification Learner кликните по стреле, чтобы открыть галерею, и затем нажать Confusion Matrix (Test) в группе Test Results.

Отобразите кривую ROC. В разделе Plots кликните по стреле, чтобы открыть галерею, и затем нажать ROC Curve (Test) в группе Test Results.

Для примера смотрите, что Эффективность Классификатора Проверки Использует Набор тестов в Приложении Classification Learner. Для примера, который использует метрики набора тестов в рабочем процессе гипероптимизации параметров управления, смотрите, Обучают Классификатор Используя Гипероптимизацию параметров управления в Приложении Classification Learner.