Сформируйте регулятор "линейного квадратичного гауссова" (LQG)

rlqg = lqgreg(kest,k)

rlqg = lqgreg(kest,k,controls)

rlqg = lqgreg(kest,k) возвращает регулятор LQG rlqg (модель в пространстве состояний), учитывая Оценку состояния фильтра Калмана kest и усиление обратной связи состояния матричный k. Те же указатели на функцию, и непрерывные - и случаи дискретного времени. Используйте сопоставимые инструменты, чтобы разработать kest и k:

Непрерывный регулятор для непрерывного объекта: используйте lqr или lqry и kalman

Дискретный регулятор для дискретного объекта: используйте dlqr или lqry и kalman

Дискретный регулятор для непрерывного объекта: используйте lqrd и kalmd

В дискретное время lqgreg производит регулятор

когда kest является "текущая" Оценка состояния фильтра Калмана

когда kest является "задержанная" Оценка состояния фильтра Калмана

Для получения дополнительной информации об Оценках состояния фильтра Калмана смотрите страницу с описанием kalman.

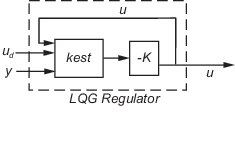

rlqg = lqgreg(kest,k,controls) средства оценки указателей, которые имеют доступ к дополнительному детерминированному известному объекту, вводят ud. Индексный вектор, который затем задает controls, какие входные параметры средства оценки являются средствами управления u и получившийся регулятор LQG rlqg, имеет ud и y как входные параметры (см. следующую фигуру).

Всегда используйте позитивные отклики, чтобы соединить регулятор LQG с объектом.

Смотрите пример Регулирование LQG: Тематическое исследование Металлопрокатного завода.

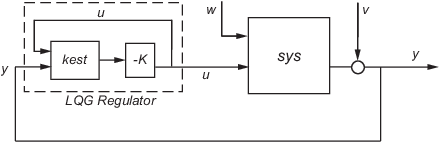

lqgreg формирует регулятор "линейного квадратичного гауссова" (LQG) путем соединения Оценки состояния фильтра Калмана, разработанной с kalman и оптимальным усилением обратной связи состояния, разработанным с lqr, dlqr или lqry. Регулятор LQG минимизирует некоторую квадратичную функцию стоимости, которая обменивает производительность регулирования и усилие по управлению. Этот регулятор является динамическим и полагается на шумные выходные измерения, чтобы сгенерировать команды регулирования.

В непрерывное время регулятор LQG генерирует команды

где оценка состояния Кальмана. Уравнения пространства состояний регулятора

где y является вектором объекта выходные измерения (см. kalman для фона и обозначения). Следующая схема показывает этому динамическому регулятору относительно объекта.

В дискретное время можно сформировать регулятор LQG, использующий любого задержанная оценка состояния из x [n], на основе измерений до y [n–1] или оценка текущего состояния , на основе всех доступных измерений включая y [n]. В то время как регулятор

всегда четко определено, текущий регулятор

является причинным только, когда I-KMD является обратимым (см. kalman для обозначения). Кроме того, практические реализации текущего регулятора должны позволить в течение времени вычислений, требуемого вычислить u [n] после измерений, y [n] становится доступным (это составляет задержку обратной связи).

Для объекта дискретного времени с уравнениями:

соединение "текущей" Оценки состояния фильтра Калмана к усилению LQR оптимально только, когда![]() и y [n] не зависит от w [n] (H = 0). Если эти условия не удовлетворены, вычисляют оптимальный контроллер LQG, использующий

и y [n] не зависит от w [n] (H = 0). Если эти условия не удовлетворены, вычисляют оптимальный контроллер LQG, использующий lqg.